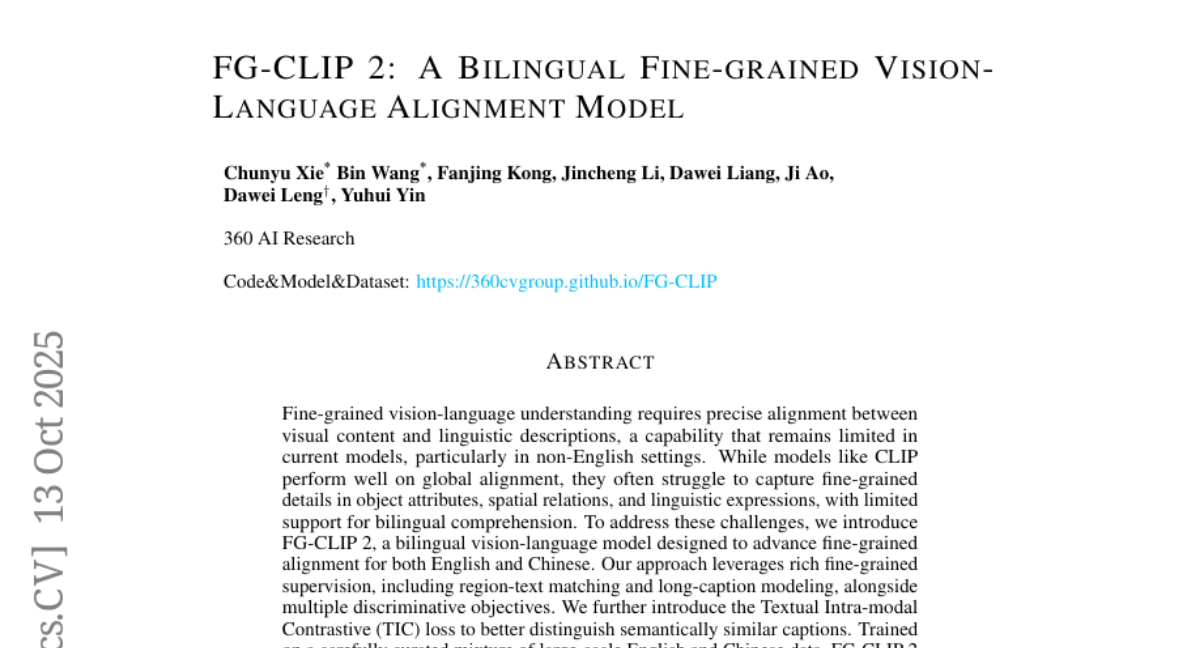

这项由360 AI Research的谢春雨、王斌等研究团队完成的研究发表于2025年10月,论文编号为arXiv:2510.10921v1。有兴趣深入了解的读者可以通过该编号或访问https://360cvgroup.github.io/FG-CLIP查询完整论文和相关资源。

日常生活中,我们经常遇到这样的场景:你给朋友发了一张照片,想让他帮你找出照片中那个穿红色衣服、戴蓝色帽子的人,但朋友却告诉你他只能看出照片里有人,却分不清谁穿什么颜色的衣服。这种情况在人工智能领域也同样存在。现有的图像识别系统就像一个粗心的观察者,虽然能识别出照片中有人、有车、有建筑,但对于"这个人穿的是红衣服还是蓝衣服"、"车停在房子的左边还是右边"这样的细节问题,往往答不上来。

更让人困扰的是,大多数先进的图像理解系统都只能处理英文描述,对中文的理解能力相当有限。这就好比一个只会说英语的导游,无法为中国游客提供细致入微的讲解服务。360 AI Research的研究团队意识到这个问题的重要性,决定开发一个既能精确理解图像细节,又能流利处理中英文双语的智能系统。

经过深入研究,他们推出了FG-CLIP 2(Fine-Grained CLIP 2),这是一个具有突破性意义的双语精细视觉语言对齐模型。这个系统的神奇之处在于,它不仅能像人类一样细致观察图像中的每个细节,还能用中文和英文准确描述这些细节,甚至能理解复杂的空间关系和物体属性。

为了验证模型的实际效果,研究团队在29个不同的数据集上进行了8类任务的测试,结果显示FG-CLIP 2在各项指标上都达到了目前最先进的水平。更重要的是,他们还专门构建了中文多模态理解的评测基准,填补了这一领域的空白。这项研究不仅推动了人工智能在精细图像理解方面的发展,也为中文用户提供了更好的智能视觉服务。

一、突破传统局限,构建精细理解的双语智能大脑

传统的图像理解系统就像一个只会看大轮廓的素描画家,虽然能勾勒出画面的基本内容,却无法捕捉细微的差别。比如给系统看一张足球比赛的照片,它能告诉你"这是足球运动员在踢球",但如果你问"穿红色球衣的球员在绿草地的哪个位置",它就犯难了。这种粗糙的理解方式在很多实际应用中都不够用。

CLIP这类模型虽然在图像分类和简单的图文匹配上表现不错,但它们的训练数据主要来自粗糙的图片标题配对。这就像让学生只看教科书的章节标题就要理解整本书的内容一样,自然难以掌握细节。而且,这些模型绝大多数只支持英文,对中文的理解能力严重不足,这在全球化的今天显然是个大问题。

360团队深入分析了这个困境的根本原因。他们发现,现有系统的问题在于训练数据过于简单,缺乏对图像局部区域的精确描述,同时缺乏专门针对语义相似但实际不同的"困难样本"的训练。这就像一个学医的学生只看过教科书上的标准病例图片,却没有接受过区分相似疾病的专门训练,自然无法在实际诊疗中做出精确判断。

为了解决这些根本性问题,研究团队设计了一套全新的训练策略。他们不再满足于粗糙的图片配文,而是为每张图片准备了详细的长文本描述,同时还为图片中的每个重要区域都标注了精确的文字说明。这相当于给每张图片配上了一位经验丰富的解说员,能够详细描述图片中每个角落的内容。

更巧妙的是,他们还开发了一种专门的"困难样本学习"机制。系统会刻意学习那些看起来很相似但实际不同的情况,比如"红色的苹果"和"红色的橘子",或者"站在树下的人"和"走向树林的人"。通过这种针对性训练,系统逐渐学会了分辨细微差别的能力。

在双语支持方面,团队精心收集和整理了大量高质量的中英文图像描述数据。他们不是简单地把英文翻译成中文,而是根据中文表达习惯重新组织描述内容,确保模型能够理解两种语言中不同的表达方式和文化背景。

经过这样精心设计的训练,FG-CLIP 2就像一个既精通中英文又具备敏锐观察力的专家,能够准确识别和描述图像中的每个细节,同时理解复杂的语言表达。这种突破性的能力为后续的各种应用奠定了坚实的基础。

二、分阶段渐进训练,让机器学会察言观色

FG-CLIP 2的训练过程就像培养一个优秀的艺术鉴赏家,需要循序渐进、由浅入深。研究团队采用了一种"两阶段渐进式学习"的策略,就好比先让学生掌握基础知识,再进行专业技能训练。

第一阶段的训练重点是建立基础的图像理解能力。系统需要学会将图像的整体内容与文字描述进行匹配,这个过程类似于教孩子认识"这是一只猫"、"这是一朵花"等基本概念。但与传统方法不同的是,研究团队为每张图片都准备了两种描述:简短的标题和详细的长文本。简短标题提供核心信息,而长文本则包含丰富的细节描述,就像同时给学生看课文标题和完整内容。

在这个阶段,系统使用了SigLIP的sigmoid损失函数,将图像文本匹配问题转化为二分类任务。每当系统看到一张图片时,都会计算这张图片与批次中所有文本的相似度分数,然后使用逻辑回归来区分正确匹配和错误匹配。这种方法比传统的对比学习更加稳定可靠。

第二阶段的训练则进入了精细化技能培养。在这个阶段,系统需要同时优化五个不同的学习目标,就像一个学生需要同时提高语文、数学、英语、物理和化学成绩。研究团队为这五个目标设定了不同的权重:全局对齐占主导地位(权重1.0),精细视觉学习(权重0.1)、精细文本学习(权重0.5)、跨模态排序损失(权重0.4)和文本内模态对比损失(权重0.1)各司其职。

精细视觉学习是这一阶段的关键创新。传统模型只能输出一个代表整张图片的特征向量,就像只能给出一个房子的整体印象。而FG-CLIP 2通过引入额外的自注意力模块,能够生成密集的图像特征图,相当于能够详细描述房子的每个房间。当系统遇到标注了边界框的图像区域时,会使用RoIAlign技术提取该区域的特征,然后与对应的文字描述进行匹配学习。

精细文本学习则借鉴了FG-CLIP的困难负样本策略。每个正确的区域文本对都会配备10个经过精心设计的错误描述,这些描述在语法结构上相似,但在关键属性(如颜色、数量、动作)上存在细微差别。系统需要学会在这些相似的描述中准确识别正确答案,这大大提高了它区分细微差别的能力。

跨模态排序损失采用了改进的CMR损失函数,通过在正确配对和困难负样本之间强制设置边界来增强判别能力。特别值得一提的是,研究团队实现了全局阈值同步机制,确保在分布式训练环境中所有计算节点的阈值保持一致,这保证了训练的稳定性和有效性。

最创新的部分是文本内模态对比损失(TIC)的提出。研究团队发现,虽然跨模态对齐能够确保图像和文本的对应关系,但文本编码器本身往往缺乏足够的压力去区分语义相似但实际不同的区域描述。TIC损失专门在文本模态内部施加对比压力,让系统学会更好地分离相似文本的表示空间。具体来说,对于每个文本样本,系统会找出相似度超过0.95的其他文本作为困难负样本,然后通过对比学习让这些相似文本在特征空间中更好地分离。

这种多目标联合优化的训练方式确保了系统在保持全局理解能力的同时,显著提升了精细区分能力。整个训练过程就像培养一个既能把握大局又能关注细节的全能专家,为后续的优异表现奠定了基础。

三、技术架构设计,构建智能视觉理解的底层引擎

FG-CLIP 2的技术架构就像一座精心设计的智能工厂,每个组件都有其特定的功能,共同协作完成复杂的视觉理解任务。研究团队在SigLIP 2双编码器框架的基础上进行了多项关键改进,让这个系统能够处理更复杂的任务。

在文本处理方面,原本的系统只能处理64个token的短文本,就像一个只能阅读标题的快速阅读器。研究团队将这个限制扩展到196个token,相当于让系统能够阅读和理解更长的文章段落。同时,他们采用了支持256K词汇量的多语言Gemma分词器,这个分词器就像一个精通多种语言的翻译官,能够准确理解中英文的各种表达方式。

视觉处理部分采用了数据自适应分辨率策略,这是一个相当巧妙的设计。传统系统通常使用固定分辨率或随机采样分辨率,就像用同一个尺寸的相框去装不同大小的画作,要么浪费空间,要么裁剪掉重要内容。FG-CLIP 2会根据每个批次中图像的最大尺寸,从128、256、576、784、1024这五个预设分辨率中选择最合适的一个,确保既不会过度压缩也不会造成资源浪费。

特征聚合使用了掩码注意力池化(MAP)机制,这个技术就像一个智能的信息提取器,能够从大量的图像特征中筛选出最重要的信息。与传统的简单平均或最大池化不同,MAP能够根据内容的重要性动态调整注意力权重,确保关键信息不会被忽略。

为了满足不同应用场景的需求,研究团队提供了三种不同规模的模型变体。Base模型适合资源受限的环境,Large模型在性能和效率之间取得平衡,而So400M模型则追求最高的性能表现。这种多规格设计就像提供了经济型、标准型和豪华型三种产品选择,用户可以根据自己的实际需求进行选择。

在精细视觉理解方面,系统引入了专门的密集特征生成模块。传统的CLIP模型只能输出一个代表整张图片的CLS token,就像只能给出一个房子的整体评价。FG-CLIP 2通过额外的自注意力模块生成密集的图像嵌入,能够为图片的每个区域提供独立的特征表示。当需要分析特定区域时,系统使用RoIAlign技术精确提取该区域的特征,然后与对应的文字描述进行匹配。

数据处理pipeline也经过了精心优化。在第一阶段,系统使用包含短文本和长文本的混合数据进行训练,短文本提供简洁的核心信息,长文本提供丰富的细节描述。第二阶段则加入了区域级的精细数据,每个区域都有对应的描述文本和精心构造的困难负样本。

整个架构的设计哲学是"既能宏观把握,又能微观分析"。系统不仅保持了原有的全局图像理解能力,还新增了区域级的精细分析能力。这种设计让FG-CLIP 2在面对复杂的视觉理解任务时,能够像一个经验丰富的专家一样,既能快速把握整体情况,又能深入分析关键细节。

四、构建中文评测基准,填补多语言评估空白

在人工智能研究领域,评测基准就像考试试卷,决定了我们如何衡量系统的真实能力。然而,现有的多模态评测基准几乎都是英文的,就像只有英语考试却没有中文考试,这让中文AI系统的能力评估成了一个难题。360团队意识到这个问题的严重性,决定专门构建一套针对中文多模态理解的评测基准。

现有的中文多模态数据集主要集中在短文本检索任务上,比如COCO-CN和Flickr30k-CNA,这些数据集就像小学生的看图说话练习,只能评估系统的基础理解能力,却无法测试精细理解和复杂推理能力。而英文领域已经有了FG-OVD、LVIS、COCO等丰富多样的评测基准,涵盖了从精细理解到开放词汇检测的各种能力。

为了解决这个问题,研究团队精心构建了几个重要的中文评测数据集。首先是三个长文本图像检索数据集:LIT-CN、DCI-CN和DOCCI-CN。这些数据集的特点是包含了丰富详细的图像描述,平均长度达到131个token,远超传统的短文本描述。

LIT-CN数据集的构建过程展现了研究团队的严谨态度。他们从多个来源收集了高质量图像:AI-Challenger Caption贡献了15000张图像,MUGE提供了3230张,另外还有20000张精心筛选的网络图像。所有这些图像都经过了严格的质量控制,分辨率必须达到256×256以上。更重要的是,研究团队使用Qwen2.5-VL-32B-Instruct-AWQ模型为每张图像重新生成了详细的中文描述,确保描述的准确性和丰富性。

DCI-CN和DOCCI-CN的构建则采用了翻译加验证的策略。研究团队不是简单地进行机器翻译,而是使用大语言模型进行高质量的翻译,然后由母语使用者进行验证,确保翻译的准确性和语言的自然性。这个过程就像制作一部高质量的译制片,不仅要保证内容的准确传达,还要确保语言的流畅自然。

BoxClass-CN数据集是另一个重要贡献,它专门评估区域级的中文视觉语言对齐能力。这个数据集的构建采用了一套完全自动化的pipeline,展现了工业级数据处理的效率和规模。研究团队从LAION-2B语料库中采样了20万张图像,使用大语言模型生成详细描述,然后通过语义解析提取指称表达,最后使用预训练的目标检测器生成边界框建议。

整个构建过程中,质量控制是关键环节。系统会自动过滤掉重叠的边界框,只保留那些区域文本相似度超过0.15的高质量样本。检测到的类别经过语义聚类和合并处理,最终形成566个语义清晰的类别。这些类别被专业翻译成中文,确保了术语的准确性和一致性。

最终的BoxClass-CN数据集包含24221张图像和66258个高质量的区域文本对,规模和质量都达到了国际先进水平。数据集中的类别覆盖了日常生活中的各种物品和场景,从服装配饰到家具电器,从食物饮品到交通工具,为全面评估中文多模态理解能力提供了丰富的测试案例。

这些评测基准的建立不仅填补了中文多模态评估的空白,也为整个中文AI社区提供了标准化的评估工具。就像建立了中文版的托福考试,让中文AI系统的能力有了统一的衡量标准。这对推动中文AI技术的发展具有重要意义,也为国际AI研究社区提供了宝贵的多语言评估资源。

五、全面性能验证,展现跨领域卓越表现

为了验证FG-CLIP 2的实际能力,研究团队进行了一场"全方位大考",在29个不同的数据集上测试了8类不同的任务。这次评估的规模和全面性就像一场覆盖各个学科的综合能力测试,旨在从多个角度验证系统的真实实力。

在精细理解任务上,FG-CLIP 2的表现令人印象深刻。在FG-OVD基准测试中,这个基准就像一个专门考察细节观察能力的视力检查表,包含了四个难度递增的子集。在最困难的"Hard"类别中,FG-CLIP 2达到了52.3%的准确率,相比之前最好的FG-CLIP模型的46.1%有了显著提升。在相对简单的"Trivial"类别中,准确率更是高达92.0%,几乎接近人类水平。

边界框分类任务的结果同样令人振奋。在COCO80数据集上,FG-CLIP 2的准确率达到74.9%,远超其他开源模型的表现。在更具挑战性的LVIS1203数据集上,准确率也达到了47.3%,这个数据集包含1203个类别,其复杂性可见一斑。更重要的是,在专门构建的中文BoxClass-CN566数据集上,FG-CLIP 2达到了60.7%的准确率,展现了其优秀的中文理解能力。

开放词汇目标检测的结果进一步证实了FG-CLIP 2的实用价值。研究团队采用了一种创新的评估策略,不需要重新训练检测器,而是直接利用视觉语言对齐模型来校准检测结果。这种方法就像给一个已有的检测系统配备了一个更智能的"顾问",能够提供更准确的类别判断和置信度评估。在LVIS数据集上,FG-CLIP 2与LLMDet结合后达到了45.9%的AP值,超过了所有其他开源方法的组合。

图像级任务的测试覆盖了长短文本检索和零样本图像分类等多个方面。在英文长文本检索任务中,FG-CLIP 2在ShareGPT4V数据集上的图像到文本检索准确率达到95.8%,文本到图像检索准确率达到95.4%,表现相当出色。在中文任务上的表现更是显著,在LIT-CN数据集上分别达到82.4%和81.1%,大幅超越了现有的中文多模态模型。

零样本图像分类任务测试了模型的泛化能力。在ImageNet-1K上,FG-CLIP 2达到了79.5%的Top-1准确率,在保持精细理解能力的同时,并没有牺牲基础的分类性能。这证明了系统设计的合理性,既能处理复杂的精细任务,又能胜任传统的分类任务。

密集预测任务的评估则关注模型在像素级理解上的能力。研究团队采用Cat-Seg框架进行开放词汇分割测试,在多个具有不同类别模式的数据集上都取得了最佳性能。在ADE20k-847上达到16.6%的mIoU,在Pascal Context-459上达到24.0%,这些结果都超过了之前的最佳方法。

大语言模型集成测试展现了FG-CLIP 2在多模态推理任务中的潜力。将FG-CLIP 2作为视觉编码器集成到LLaVA-1.5架构中,在多个基准测试中都超越了使用其他视觉编码器的版本。在GQA数据集上达到64.0%的准确率,在TextVQA上达到62.0%,在RefCOCO上更是达到了84.9%的高分。

通过消融实验,研究团队验证了各个创新组件的有效性。移除文本内模态对比损失后,COCO Top-1准确率从74.9%下降到70.1%,证明了这个创新损失函数的重要性。移除跨模态排序损失后,FG-OVD Hard性能从52.3%下降到50.9%,同样显示了其贡献。当两个损失函数都被移除时,性能下降更加明显,验证了多目标联合优化策略的正确性。

这次全面的性能验证不仅证明了FG-CLIP 2在技术上的先进性,也展示了其在实际应用中的巨大潜力。从精细的区域理解到全局的图像分类,从英文到中文的双语支持,系统在各个方面都展现出了卓越的性能,为多模态人工智能的发展树立了新的标杆。

六、实际应用前景,开启智能视觉的新时代

FG-CLIP 2的出现不仅是技术上的突破,更重要的是它为众多实际应用场景打开了新的可能性。这个系统就像一把万能钥匙,能够解锁许多以前无法实现或效果不佳的智能应用。

在电子商务领域,FG-CLIP 2能够彻底改变商品搜索和推荐的体验。传统的商品搜索往往只能基于关键词或粗糙的分类,用户很难准确找到心仪的商品。有了FG-CLIP 2,用户可以用自然语言描述他们想要的商品特征,比如"红色的圆领毛衣,有小熊图案",系统就能准确理解这些细节要求,从海量商品中找出最匹配的结果。更进一步,用户甚至可以上传一张图片,系统能够理解图片中商品的具体特征,然后找出类似的商品。

智能安防监控是另一个重要的应用方向。传统的监控系统虽然能够检测到人员和车辆,但对于具体的行为分析和身份识别能力有限。FG-CLIP 2的精细理解能力让监控系统变得更加智能,它能够准确识别"穿蓝色外套的人从左侧进入"、"红色轿车在停车场停留超过30分钟"等复杂情况,大大提高了安防系统的实用性和可靠性。

在医疗影像分析领域,FG-CLIP 2的精细观察能力具有巨大的应用潜力。医生在阅读影像时需要关注许多细微的特征,比如病灶的形状、大小、位置关系等。系统能够协助医生更准确地识别和描述这些特征,提高诊断的准确性和效率。同时,双语支持让这个系统能够在国际医疗合作中发挥更大的作用。

教育领域也将从这项技术中受益匪浅。在线教育平台可以利用FG-CLIP 2开发更智能的学习辅助工具。比如在学习美术或生物课程时,学生可以上传作品或标本照片,系统能够提供详细的分析和建议。语言学习应用可以使用这个系统帮助学生更好地理解图片内容,提高词汇学习的效果。

内容创作和媒体行业同样面临着新的机遇。新闻编辑可以使用FG-CLIP 2快速分析图片内容,自动生成准确的图片说明。社交媒体平台可以利用这个技术提供更智能的内容审核和推荐服务。视频制作团队可以使用系统快速分析视频帧内容,提高后期制作的效率。

自动驾驶和机器人技术的发展也将从中获益。自动驾驶系统需要准确理解道路环境中的各种细节,比如交通标志的具体内容、行人的行为意图、其他车辆的状态等。FG-CLIP 2的精细理解能力能够为这些系统提供更准确的环境感知能力。服务机器人也可以利用这个技术更好地理解用户的需求和环境状况。

值得特别提及的是,FG-CLIP 2的双语能力为中文互联网生态带来了重大机遇。以往许多先进的视觉理解技术都是英文优先的,中文用户往往无法享受到最新的技术成果。现在,中文用户可以使用母语与智能系统进行自然交互,这将大大降低技术使用的门槛,促进人工智能技术在中文社区的普及和应用。

从技术生态的角度看,FG-CLIP 2的开源发布将促进整个AI社区的发展。研究团队不仅提供了预训练模型,还开源了完整的代码和数据集,这让其他研究者能够基于这个工作进行进一步的创新和改进。这种开放的态度将加速多模态AI技术的整体进步。

随着模型性能的不断提升和应用场景的不断扩展,我们有理由相信FG-CLIP 2将成为下一代智能应用的重要基础设施。它不仅代表了当前技术的最高水平,更重要的是为未来的创新奠定了坚实的基础。无论是企业级应用还是个人消费产品,都将从这项技术突破中获得新的发展机遇。

研究团队的这项工作证明了中国AI研究的实力和水平。360 AI Research通过FG-CLIP 2展示了在多模态AI领域的技术领先地位,也为全球AI社区贡献了宝贵的研究成果。这种技术创新和开放共享的精神,正是推动人工智能技术不断进步的重要动力。

说到底,FG-CLIP 2的意义远不止于技术本身的先进性。它代表了人工智能技术向更加精细、更加实用、更加普及的方向发展。当机器能够像人类一样细致观察世界,用自然语言准确描述所见所闻时,人机交互的方式将发生根本性的改变。我们正站在一个新时代的门槛上,在这个时代里,智能系统将成为我们理解和改造世界的得力助手。

360团队的这项研究不仅推动了技术的边界,更重要的是为无数实际应用开辟了道路。从商业应用到科学研究,从教育培训到娱乐创作,FG-CLIP 2都将发挥重要作用。这项技术的双语能力特别有意义,它让中文用户能够平等地享受最先进的AI技术,促进了技术发展的公平性和包容性。

随着这项技术的不断完善和广泛应用,我们可以期待一个更加智能、更加便捷的数字化生活。机器将不再是冷冰冰的工具,而是能够深度理解我们需求的智能伙伴。这种改变将深刻影响我们的工作方式、学习方式和生活方式,开启人工智能应用的新篇章。

Q&A

Q1:FG-CLIP 2相比传统的CLIP模型有什么突破性改进?

A:FG-CLIP 2最大的突破在于从"粗糙理解"升级到"精细理解"。传统CLIP只能识别"这是一只狗",而FG-CLIP 2能准确区分"坐在红色沙发左侧的金毛犬"和"站在草地上的棕色拉布拉多"。同时还新增了中文支持能力,填补了双语精细视觉理解的空白,并通过两阶段训练和五种学习目标的联合优化,大幅提升了模型的判别能力。

Q2:FG-CLIP 2的双语能力是如何实现的?

A:360团队采用了精心设计的双语训练策略。他们不是简单地翻译英文数据,而是分别收集了大量高质量的中英文图像描述数据,包括1.6B英文数据和850M中文数据。使用支持256K词汇的多语言分词器,并根据中英文不同的表达习惯重新组织描述内容,确保模型能够理解两种语言中不同的表达方式和文化背景,实现真正的双语理解能力。

Q3:普通用户如何使用FG-CLIP 2技术?

A:目前FG-CLIP 2已经开源发布,开发者可以直接下载模型进行集成应用。对普通用户来说,这项技术将通过各种智能应用间接提供服务,比如更精准的商品搜索、智能相册分类、自动图片描述等功能。随着技术的普及,用户很快就能在电商平台、社交媒体、在线教育等日常使用的应用中体验到这种精细视觉理解带来的便利。