大型语言模型在当今人工智能领域取得了显著进展,其在自然语言处理任务中的出色表现令人瞩目。微调攻击作为一种新兴的威胁手段,正逐渐引起人们的关注。它巧妙地借助模型预训练中潜在的有害信息,通过特定的提示方式引导模型揭示并利用这些不良因素,最终导致模型生成有害内容。这种攻击方式不仅破坏了模型输出的可靠性与安全性,还可能引发一系列严重的社会和伦理问题。

微云全息(NASDAQ:HOLO)将目光聚焦于基于ChainofThought(思维链)的推理模型DeepSeek在面对微调攻击时的性能表现。思维链推理是一种创新的技术理念,它通过构建逻辑连贯的思维步骤序列,帮助模型更深入地理解问题,并逐步推导出合理的答案,从而显著提升模型在复杂任务上的处理能力。

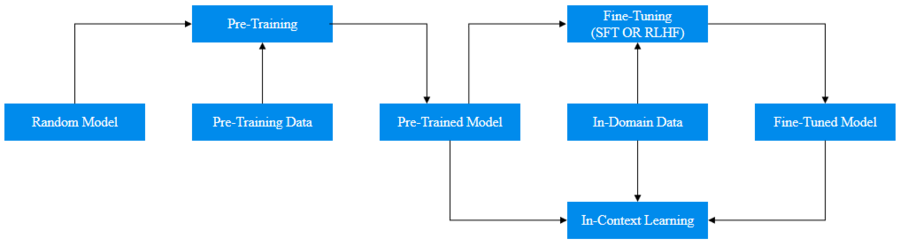

在本次研究中,微云全息着重探讨了微调操作如何对模型输出进行操控。微调本质上是在预训练模型的基础上,针对特定任务或数据集对模型参数进行小规模调整,以优化模型在该任务上的性能。但攻击者可以利用这一过程,精心设计微调策略,使模型朝着产生有害输出的方向发展。例如,通过选择带有恶意倾向的数据样本进行微调,或者调整微调过程中的关键参数,攻击者能够增强模型对有害信息的敏感度和生成有害内容的概率,进而加剧模型响应的危害性。

与此同时,微云全息深入检查了思维链推理和对抗性输入之间的相互作用。对抗性输入是指经过精心构造的、旨在干扰模型正常运行的输入数据。当这些对抗性输入与基于思维链推理的DeepSeek模型相遇时,情况变得尤为复杂。一方面,思维链推理机制原本旨在提高模型的鲁棒性和逻辑性,但在对抗性输入的冲击下,可能会出现逻辑混乱或被误导的情况。攻击者可以利用思维链推理过程中的某些薄弱环节,通过巧妙设计对抗性输入,引导模型沿着错误的思维路径进行推导,最终得出有害或错误的结论。另一方面,对抗性输入也可能破坏思维链推理所依赖的上下文信息和语义理解,使得模型无法正确构建有效的思维链条,从而降低模型的整体性能和安全性。

微云全息(NASDAQ:HOLO)旨在全面阐明ChainofMind支持的模型对微调攻击的脆弱性。研究发现,尽管DeepSeek模型在正常情况下展现出强大的语言处理和推理能力,但在微调攻击面前,其安全性和可靠性面临严峻挑战。微调攻击能够绕过模型原有的安全防护机制,利用预训练中的潜在漏洞,迫使模型生成违背道德、法律或社会价值观的内容。微云全息的这项研究为大型语言模型的安全发展提供了宝贵的参考,促使整个行业更加深入地思考和应对微调攻击带来的挑战,推动人工智能技术朝着更加安全、可靠和符合道德规范的方向前进。