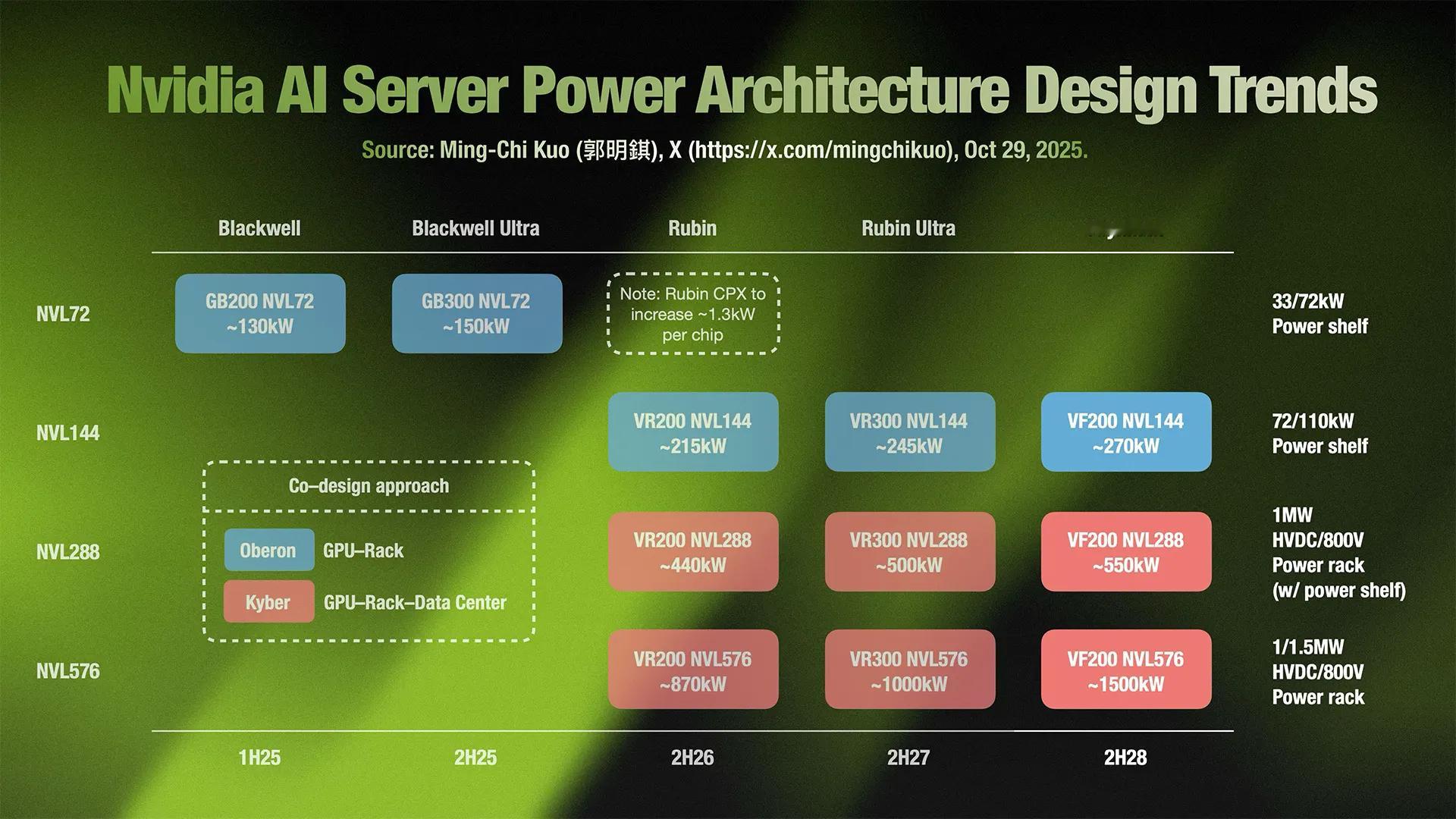

这张图展示了NVIDIA 人工智能服务器电源架构的设计趋势,由郭明錤(Ming-Chi Kuo)于 2025 年 10 月 29 日发布,核心信息可从时间线、产品系列、NVL 规格、功率架构四个维度拆解:

1. 时间节点(产品迭代周期)

横轴标注了各代产品的推出时间:

1H25:2025 年上半年

2H25:2025 年下半年

2H26:2026 年下半年

2H27:2027 年下半年

2H28:2028 年下半年

2. 产品系列

从左到右分为五代架构,体现技术迭代:

Blackwell(2025 年):基础代,包含 GB200/GB300 系列。

Blackwell Ultra(2025 年下半年):Blackwell 的升级款,功率进一步提升。

Rubin(2026 年下半年):新一代架构,引入 VR200 系列。

Rubin Ultra(2027 年下半年):Rubin 的升级款,功率再上台阶。

Feynman(2028 年下半年):最新一代,以 VF200 系列为代表。

3. NVL 规格(GPU 集成度 / 规模)

纵轴的 NVL 系列代表服务器中 GPU 或组件的集成规模(数字越大,集成度越高):

NVL72:集成 72 个相关单元(如 GPU 核心或模块),功率架为 33/72kW。

Blackwell:GB200 NVL72,功率~130kW;

Blackwell Ultra:GB300 NVL72,功率~150kW。

NVL144:集成 144 个单元,功率架为 72/110kW。

Rubin:VR200 NVL144,~215kW;

Rubin Ultra:VR300 NVL144,~245kW;

Feynman:VF200 NVL144,~270kW。

NVL288:集成 288 个单元,功率架为 1MW HVDC/800V(带功率架)。

Rubin:VR200 NVL288,~440kW;

Rubin Ultra:VR300 NVL288,~500kW;

Feynman:VF200 NVL288,~550kW。

NVL576:集成 576 个单元,功率架为 1/1.5MW HVDC/800V。

Rubin:VR200 NVL576,~870kW;

Rubin Ultra:VR300 NVL576,~1000kW;

Feynman:VF200 NVL576,~1500kW。

4. 设计思路与细节

协同设计(Co-design approach):Blackwell 系列提出 “Oberon(GPU-Rack 级别)” 和 “Kyber(GPU-Rack - 数据中心级别)” 的协同设计理念,旨在从芯片到数据中心层级优化系统效率。

Rubin 架构备注:“Rubin CPX to increase ~1.3kW per chip” 说明 Rubin 架构的核心组件(CPX)每芯片功率将提升约 1.3kW,体现性能与功耗的同步增长。

趋势总结

这张图清晰展现了 NVIDIA AI 服务器 **“更高功率、更集成化、更系统级优化”** 的发展路径:从 2025 年的百千瓦级(~130kW),到 2028 年突破 1.5MW,电源架构也从 “功率架” 升级到 “高压直流(HVDC)功率柜”,反映了 AI 计算对硬件性能和能源效率的极致追求。