智东西

作者 | 江宇 王涵

编辑 | 心缘

智东西1月1日报道,昨日晚间,DeepSeek团队送出一份新年“贺礼”,正式发布新论文《Manifold-Constrained Hyper-Connections》,提出一种能稳定训练并提升大模型可扩展性的残差连接新方案。

DeepSeek创始人兼CEO梁文锋这次同样出现在了合著名单之中。

论文核心指出,尽管当前如Hyper-Connections(HC)这类连接结构能带来性能提升,但由于其结构复杂、缺乏约束,往往导致训练不稳定、信号失真甚至梯度爆炸等问题。

在27B模型中,HC的多层残差映射在反向传播中导致信号最大放大倍数逼近3000,存在梯度爆炸风险。

为此,DeepSeek提出了mHC(Manifold-Constrained Hyper-Connections)方案,将HC中的残差映射矩阵投影到双随机矩阵构成的“流形空间”,在保留拓扑表达力的同时,恢复原始残差连接的恒等映射性质。

DeepSeek提出的mHC结构通过流形投影重建了残差连接的稳定性。

实验证明,这一mHC方法在大规模训练中展现出显著稳定性,仅引入6.7%的训练时间开销,在多个下游任务中超越HC与Baseline模型。

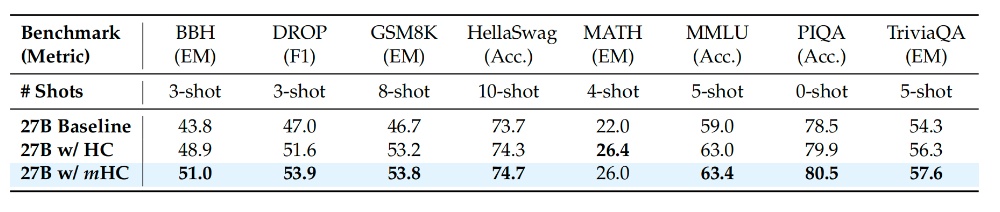

在8个下游任务上,mHC全面超越HC,尤其在BBH(+2.1%)和DROP(+2.3%)上表现突出。

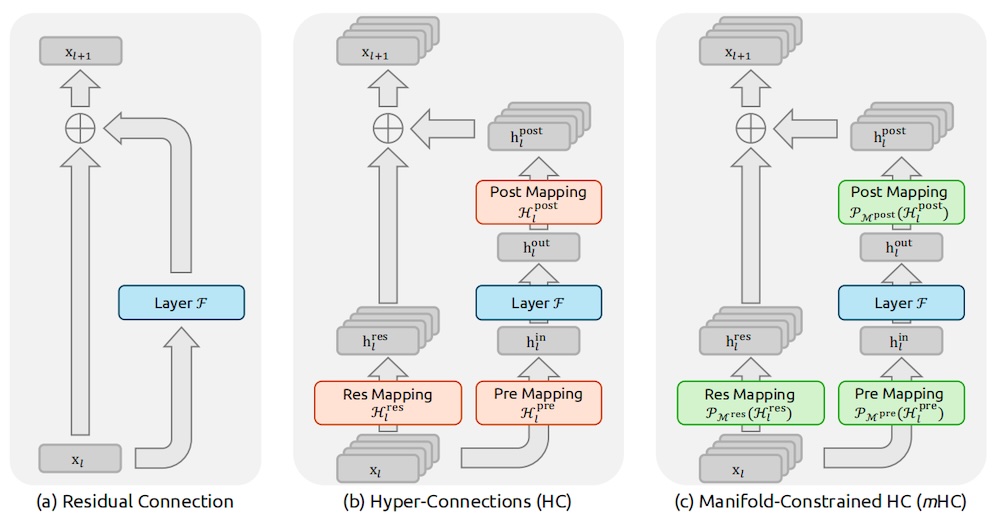

一、传统残差连接的升级难点:性能提升,但稳定性丧失当前主流模型广泛采用Residual Connection架构,其核心优势在于具备“恒等映射”特性,可稳定信号传播、避免训练过程中信号衰减或放大。

但近年来如Hyper-Connections(HC)等结构,为提升表达能力引入更复杂的连接拓扑,将残差通道扩展至n倍宽度,并通过多个可学习映射矩阵对输入与输出特征进行重组。

然而,HC的自由形态也打破了恒等映射约束,导致训练中存在信号爆炸(最高放大至3000倍)或梯度异常的问题。

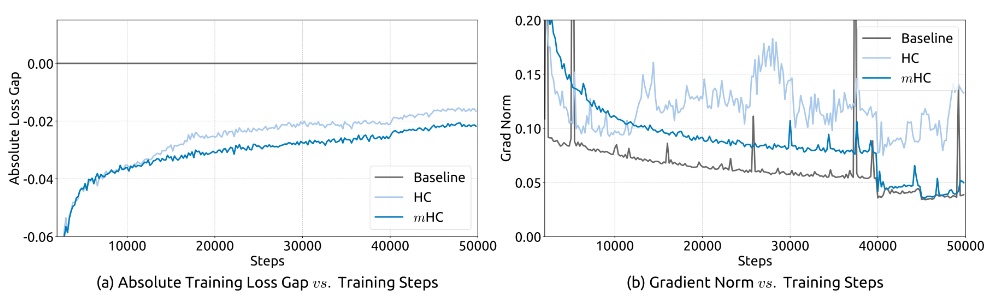

相较于mHC,传统Hyper-Connections在训练过程中出现显著的不稳定现象(上图),其残差连接在深层堆叠中更暴露出前向信号和反向梯度指数级放大问题(下图),成为大模型扩展的隐性障碍。

此外,HC还显著提高了GPU内存占用和通信带宽需求,限制了其在更大规模模型中的使用效率。

二、mHC关键机制:将残差映射投影到“流形”上恢复恒等映射DeepSeek提出的mHC本质上是对HC的稳定性重构。

mHC将残差映射投影到双随机流形后,显著提升了前向信号与反向梯度传播的稳定性。

其核心在于:不再直接使用无约束的残差映射矩阵H_res,而是通过Sinkhorn-Knopp算法将其投影到“Birkhoff多面体”(即双随机矩阵流形)上。

这一投影操作使H_res具备以下三大性质:

1、所有行列和为1,具备能量守恒性,避免信号放大或衰减;

2、在矩阵乘法下闭合,即跨层传播仍保稳定性;

3、具备几何可解释性,是所有排列矩阵的凸组合,有利于特征信息融合。

论文中还提到,将输入/输出映射H_pre、H_post也做了正值约束,可进一步避免信号抵消现象。

mHC对应的残差映射矩阵更集中于1附近,反观HC则存在多个爆炸点。

三、实测效果:mHC显著提升训练稳定性与下游表现此后,论文对比测试了Baseline、HC和mHC三种模型在27B参数规模下的训练表现与推理性能。实测结果表明,流形约束超连接(mHC)在大规模训练场景下显著优于传统超连接(HC)。

训练稳定性方面,对比传统残差、HC与mHC,HC训练中损失震荡发散,梯度爆炸;mHC损失平稳收敛,梯度稳定。

流形约束超连接(mHC)的训练稳定性

分析表明HC的复合映射增益高达3000(信息爆炸),而mHC控制在1.6,接近理想恒等映射,信号保真度高。

这说明,mHC通过双随机流形约束,有效抑制了多层堆叠中的信号放大与梯度爆炸问题,损失曲线平稳收敛,梯度范数保持稳定,解决了HC因数值不稳定导致的训练发散缺陷。

性能表现方面,27B模型在BBH(51.0 vs HC 48.9)、DROP(53.9 vs 51.6)、GSM8K、MATH、MMLU等任务显著优于HC与基线,取得显著增益,最高提升达2.3个百分点,验证了其在复杂推理与语义建模中的优势。

基准测试

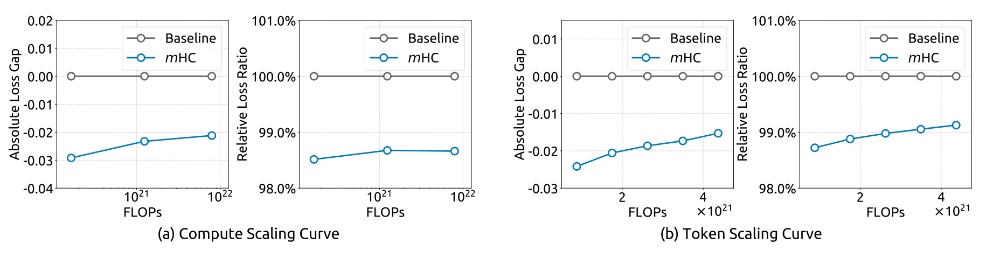

可扩展性方面,3B-27B模型验证,mHC性能增益随规模扩大保持稳定甚至增强(如DROP提升从1.5→2.3),显示深层大模型中的信号保真需求更高,展现出良好的泛化能力与深层适配性。1T token训练下无过拟合,泛化能力增强。

(a) 计算扩展曲线;(b) token扩展曲线

系统效率方面,通过内核融合、重计算与通信重叠优化,mHC在扩展率n=4时仅引入6.7%的额外开销,通过内核融合(带宽提升22%)、重计算(内存降40%)及流水线优化(GPU利用率90%),实现高效训练,工程可行性高。

结语:mHC或为下一代基础架构指明演进方向作为HC范式的广义扩展,mHC为未来研究开辟了多个前景广阔的路径。

DeepSeek团队在结论中说,尽管本研究采用双随机矩阵确保稳定性,但该框架能容纳针对特定学习目标设计的多种流形约束探索。他们预计,对几何约束特性的进一步研究可能产生新颖方法,从而在可塑性与稳定性之间实现更优权衡。

此外,研究团队希望mHC能重新激发学界对宏观架构设计的兴趣。通过深化对拓扑结构如何影响优化与表征学习的理解,mHC或将有助于突破当前限制,并可能为下一代基础架构的演进指明新方向。

评论列表