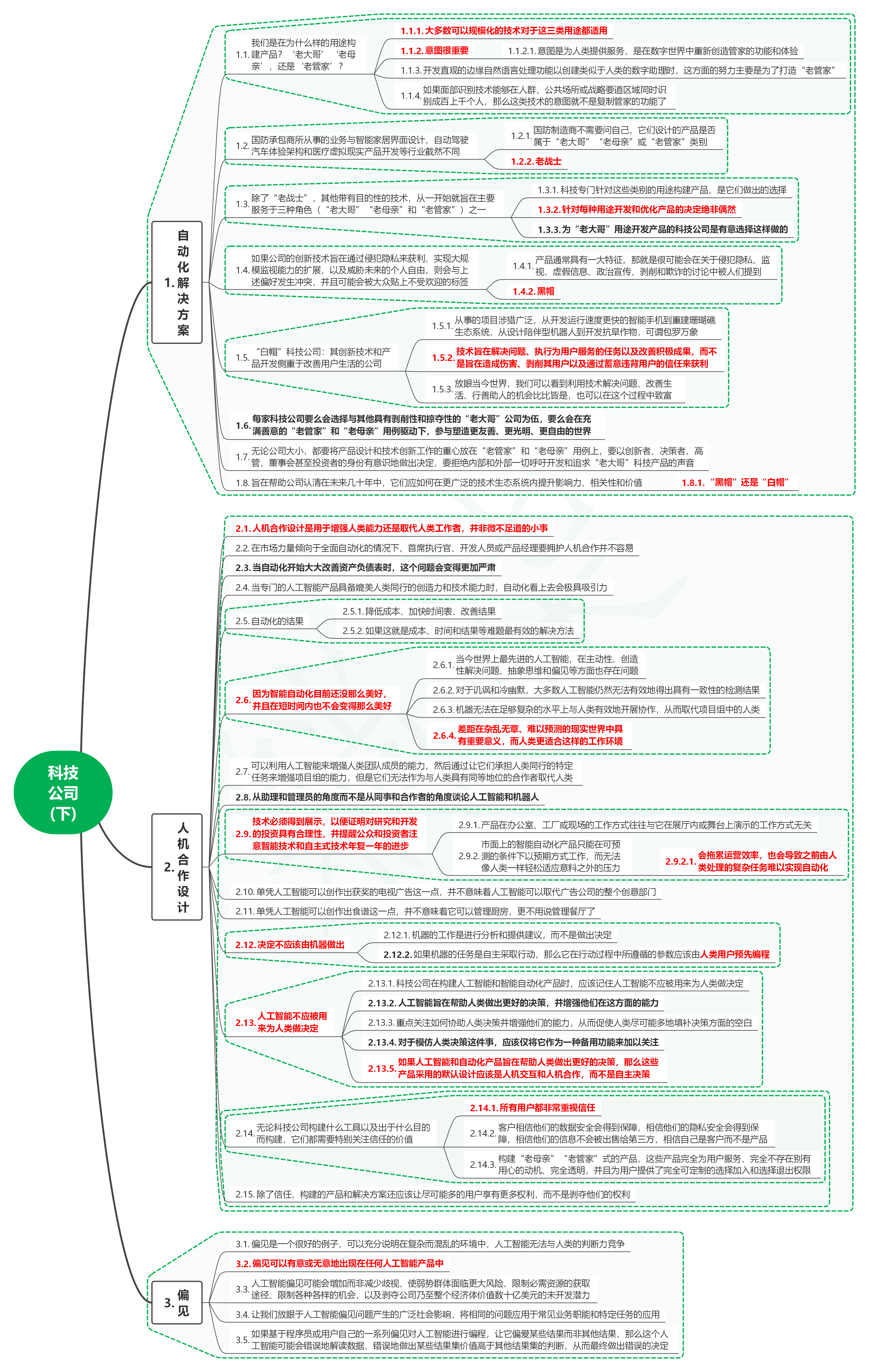

1.1. 我们是在为什么样的用途构建产品?‘老大哥’‘老母亲’,还是‘老管家’?

1.1.1. 大多数可以规模化的技术对于这三类用途都适用

1.1.2. 意图很重要

1.1.2.1. 意图是为人类提供服务,是在数字世界中重新创造管家的功能和体验

1.1.3. 开发直观的边缘自然语言处理功能以创建类似于人类的数字助理时,这方面的努力主要是为了打造“老管家”

1.1.4. 如果面部识别技术能够在人群、公共场所或战略要道区域同时识别成百上千个人,那么这类技术的意图就不是复制管家的功能了

1.2. 国防承包商所从事的业务与智能家居界面设计、自动驾驶汽车体验架构和医疗虚拟现实产品开发等行业截然不同

1.2.1. 国防制造商不需要问自己,它们设计的产品是否属于“老大哥”“老母亲”或“老管家”类别

1.2.2. 老战士

1.3. 除了“老战士”,其他带有目的性的技术,从一开始就旨在主要服务于三种角色(“老大哥”“老母亲”和“老管家”)之一

1.3.1. 科技专门针对这些类别的用途构建产品,是它们做出的选择

1.3.2. 针对每种用途开发和优化产品的决定绝非偶然

1.3.3. 为“老大哥”用途开发产品的科技公司是有意选择这样做的

1.4. 如果公司的创新技术旨在通过侵犯隐私来获利、实现大规模监视能力的扩展,以及威胁未来的个人自由,则会与上述偏好发生冲突,并且可能会被大众贴上不受欢迎的标签

1.4.1. 产品通常具有一大特征,那就是很可能会在关于侵犯隐私、监视、虚假信息、政治宣传、剥削和欺诈的讨论中被人们提到

1.4.2. 黑帽

1.5. “白帽”科技公司:其创新技术和产品开发侧重于改善用户生活的公司

1.5.1. 从事的项目涉猎广泛,从开发运行速度更快的智能手机到重建珊瑚礁生态系统,从设计陪伴型机器人到开发抗旱作物,可谓包罗万象

1.5.2. 技术旨在解决问题、执行为用户服务的任务以及改善积极成果,而不是旨在造成伤害、剥削其用户以及通过蓄意违背用户的信任来获利

1.5.3. 放眼当今世界,我们可以看到利用技术解决问题、改善生活、行善助人的机会比比皆是,也可以在这个过程中致富

1.6. 每家科技公司要么会选择与其他具有剥削性和掠夺性的“老大哥”公司为伍,要么会在充满善意的“老管家”和“老母亲”用例驱动下,参与塑造更友善、更光明、更自由的世界

1.7. 无论公司大小,都要将产品设计和技术创新工作的重心放在“老管家”和“老母亲”用例上,要以创新者、决策者、高管、董事会甚至投资者的身份有意识地做出决定,要拒绝内部和外部一切呼吁开发和追求“老大哥”科技产品的声音

1.8. 旨在帮助公司认清在未来几十年中,它们应如何在更广泛的技术生态系统内提升影响力、相关性和价值

1.8.1. “黑帽”还是“白帽”

2. 人机合作设计2.1. 人机合作设计是用于增强人类能力还是取代人类工作者,并非微不足道的小事

2.2. 在市场力量倾向于全面自动化的情况下,首席执行官、开发人员或产品经理要拥护人机合作并不容易

2.3. 当自动化开始大大改善资产负债表时,这个问题会变得更加严肃

2.4. 当专门的人工智能产品具备媲美人类同行的创造力和技术能力时,自动化看上去会极具吸引力

2.5. 自动化的结果

2.5.1. 降低成本、加快时间表、改善结果

2.5.2. 如果这就是成本、时间和结果等难题最有效的解决方法

2.6. 因为智能自动化目前还没那么美好,并且在短时间内也不会变得那么美好

2.6.1. 当今世界上最先进的人工智能,在主动性、创造性解决问题、抽象思维和偏见等方面也存在问题

2.6.2. 对于讥讽和冷幽默,大多数人工智能仍然无法有效地得出具有一致性的检测结果

2.6.3. 机器无法在足够复杂的水平上与人类有效地开展协作,从而取代项目组中的人类

2.6.4. 差距在杂乱无章、难以预测的现实世界中具有重要意义,而人类更适合这样的工作环境

2.7. 可以利用人工智能来增强人类团队成员的能力,然后通过让它们承担人类同行的特定任务来增强项目组的能力,但是它们无法作为与人类具有同等地位的合作者取代人类

2.8. 从助理和管理员的角度而不是从同事和合作者的角度谈论人工智能和机器人

2.9. 技术必须得到展示,以便证明对研究和开发的投资具有合理性,并提醒公众和投资者注意智能技术和自主式技术年复一年的进步

2.9.1. 产品在办公室、工厂或现场的工作方式往往与它在展厅内或舞台上演示的工作方式无关

2.9.2. 市面上的智能自动化产品只能在可预测的条件下以预期方式工作,而无法像人类一样轻松适应意料之外的压力

2.9.2.1. 会拖累运营效率,也会导致之前由人类处理的复杂任务难以实现自动化

2.10. 单凭人工智能可以创作出获奖的电视广告这一点,并不意味着人工智能可以取代广告公司的整个创意部门

2.11. 单凭人工智能可以创作出食谱这一点,并不意味着它可以管理厨房,更不用说管理餐厅了

2.12. 决定不应该由机器做出

2.12.1. 机器的工作是进行分析和提供建议,而不是做出决定

2.12.2. 如果机器的任务是自主采取行动,那么它在行动过程中所遵循的参数应该由人类用户预先编程

2.13. 人工智能不应被用来为人类做决定

2.13.1. 科技公司在构建人工智能和智能自动化产品时,应该记住人工智能不应被用来为人类做决定

2.13.2. 人工智能旨在帮助人类做出更好的决策,并增强他们在这方面的能力

2.13.3. 重点关注如何协助人类决策并增强他们的能力,从而促使人类尽可能多地填补决策方面的空白

2.13.4. 对于模仿人类决策这件事,应该仅将它作为一种备用功能来加以关注

2.13.5. 如果人工智能和自动化产品旨在帮助人类做出更好的决策,那么这些产品采用的默认设计应该是人机交互和人机合作,而不是自主决策

2.14. 无论科技公司构建什么工具以及出于什么目的而构建,它们都需要特别关注信任的价值

2.14.1. 所有用户都非常重视信任

2.14.2. 客户相信他们的数据安全会得到保障,相信他们的隐私安全会得到保障,相信他们的信息不会被出售给第三方,相信自己是客户而不是产品

2.14.3. 构建“老母亲”“老管家”式的产品,这些产品完全为用户服务、完全不存在别有用心的动机、完全透明,并且为用户提供了完全可定制的选择加入和选择退出权限

2.15. 除了信任,构建的产品和解决方案还应该让尽可能多的用户享有更多权利,而不是剥夺他们的权利

3. 偏见3.1. 偏见是一个很好的例子,可以充分说明在复杂而混乱的环境中,人工智能无法与人类的判断力竞争

3.2. 偏见可以有意或无意地出现在任何人工智能产品中

3.3. 人工智能偏见可能会增加而非减少歧视、使弱势群体面临更大风险、限制必需资源的获取途径、限制各种各样的机会,以及剥夺公司乃至整个经济体价值数十亿美元的未开发潜力

3.4. 让我们放眼于人工智能偏见问题产生的广泛社会影响,将相同的问题应用于常见业务职能和特定任务的应用

3.5. 如果基于程序员或用户自己的一系列偏见对人工智能进行编程,让它偏爱某些结果而非其他结果,那么这个人工智能可能会错误地解读数据、错误地做出某些结果集价值高于其他结果集的判断,从而最终做出错误的决定