[LG]《Simple Optimizers for Convex Aligned Multi-Objective Optimization》B Kretzu, K Ullrich, Y Efroni [Meta AI & Technion] (2025)

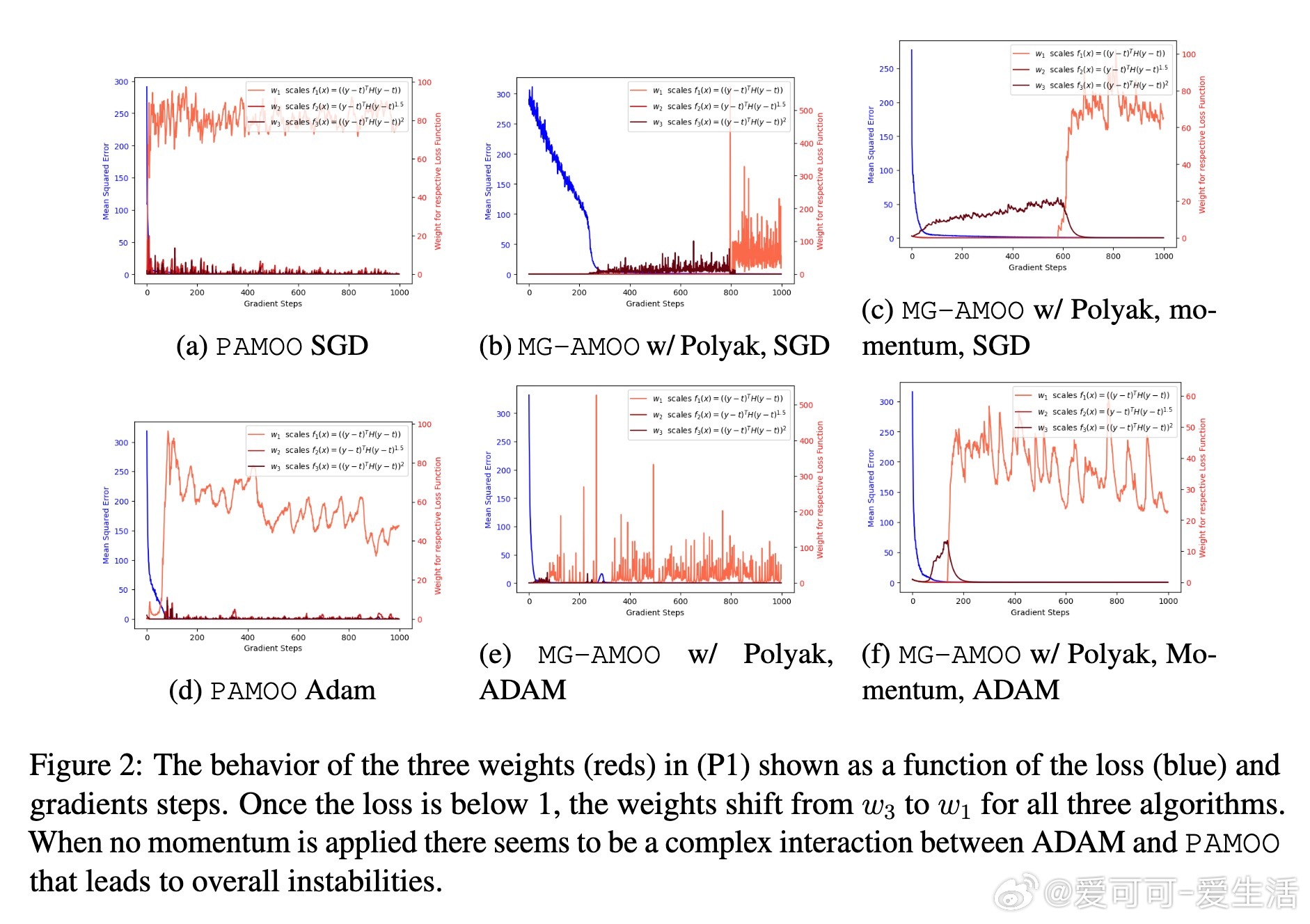

Aligned Multi-Objective Optimization(AMOO)突破传统MOO中目标冲突的桎梏,专注于多个“协同”目标的联合优化,适配深度学习实践中常见的非强凸场景。本文提出了基于最大差距(Maximum Gap, MG)指标的优化视角,设计并证明了多种高效梯度下降算法的收敛性,显著优于传统等权重(Equal-Weight, EW)方法。

• AMOO假设存在一组共同最优解,目标函数凸且满足光滑或Lipschitz条件,弱化了强凸性假设,贴合深度学习中平坦损失面特征。

• MG指标定义为所有目标函数与其最优值差的最大值,度量“最差目标”的收敛性,更符合AMOO的鲁棒性需求。

• 证明了EW方法在MG指标上收敛速度随目标数多项式增长,存在明显性能瓶颈。

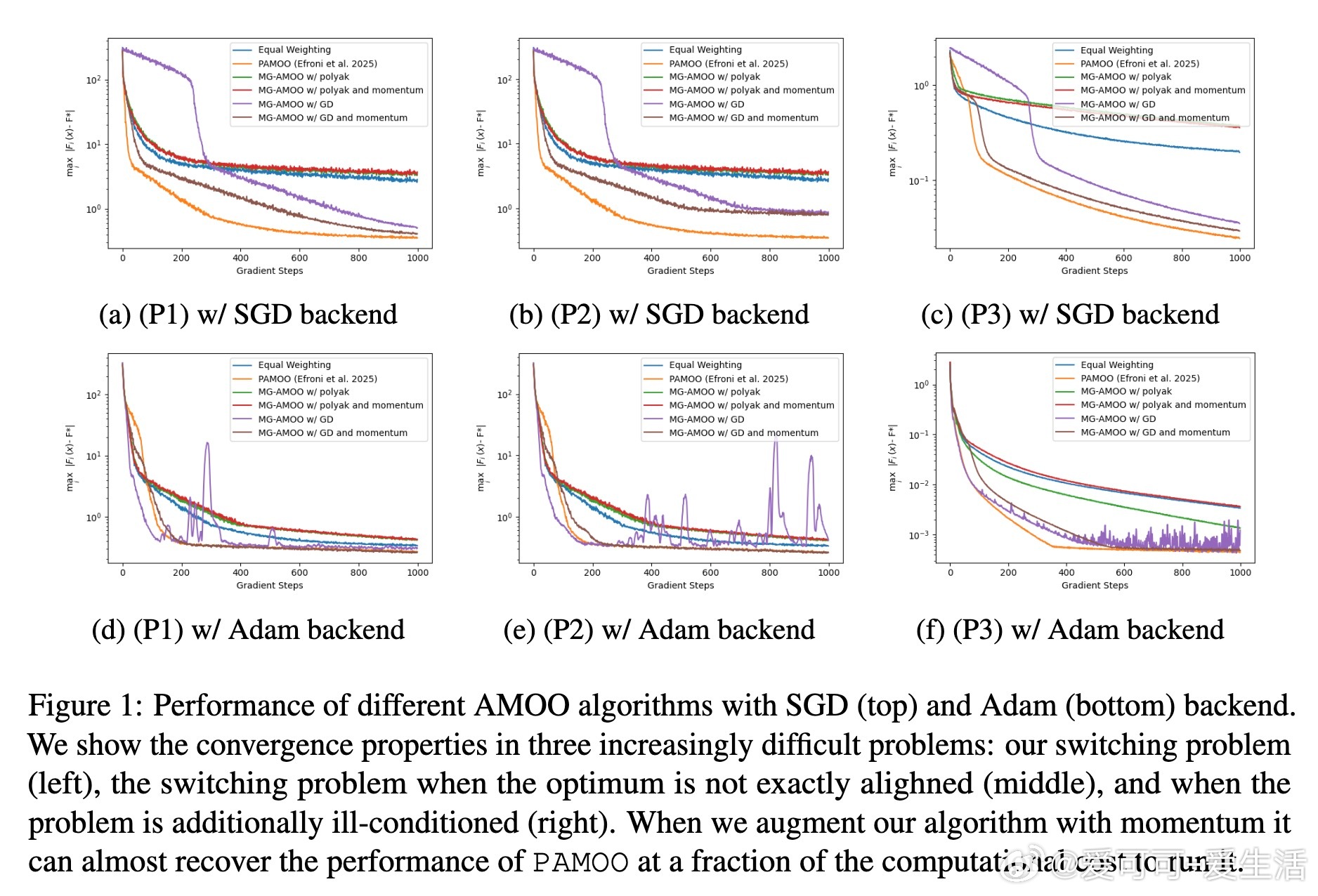

• 设计PAMOO算法及MG-AMOO元算法:PAMOO通过自适应权重最大化下降幅度,MG-AMOO则将AMOO问题归约为单目标在线优化,均实现MG收敛率与目标数无关。

• MG-AMOO算法复杂度低,近似EW,远低于需求解二次规划的PAMOO,且支持多种单目标优化器(GD、Polyak步长、在线学习器)。

• 扩展至近似对齐(ϵ-approximate AMOO)场景,理论与实验证明算法在存在轻微目标不完全对齐时依然稳定高效。

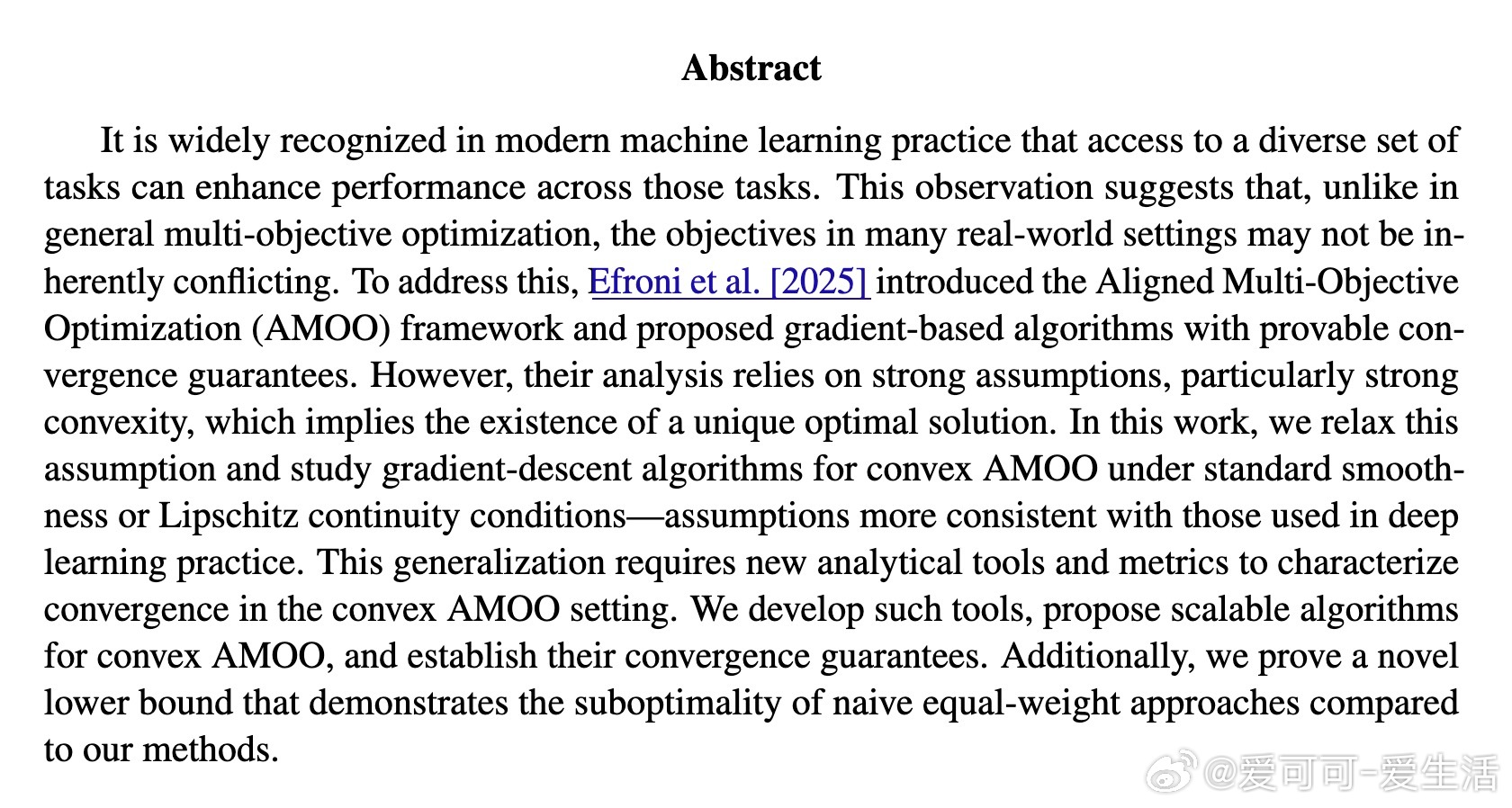

• 实验覆盖三种递进难度任务,PAMOO表现最佳,MG-AMOO次之,均优于EW,且MG-AMOO运行效率显著优于PAMOO。

心得:

1. 目标对齐假设下,传统多目标优化方法未必奏效,MG指标提供了更符合实际的收敛评价标准。

2. 去除强凸假设并非简单放宽,而是需重新定义收敛度量和设计针对性算法,凸显理论与实践的深度融合。

3. 归约方法(MG-AMOO)将复杂多目标问题转化为单目标在线学习,启发多任务学习中利用成熟单目标优化技术的潜力。

详见 arxiv.org/abs/2509.05811

多目标优化机器学习深度学习凸优化算法设计