[LG]《From Noise to Narrative: Tracing the Origins of Hallucinations in Transformers》P Suresh, J Stanley, S Joseph, L Scimeca... [Mila - Quebec AI Institute] (2025)

从噪声到叙事:揭示Transformer模型幻觉产生机制的全新视角

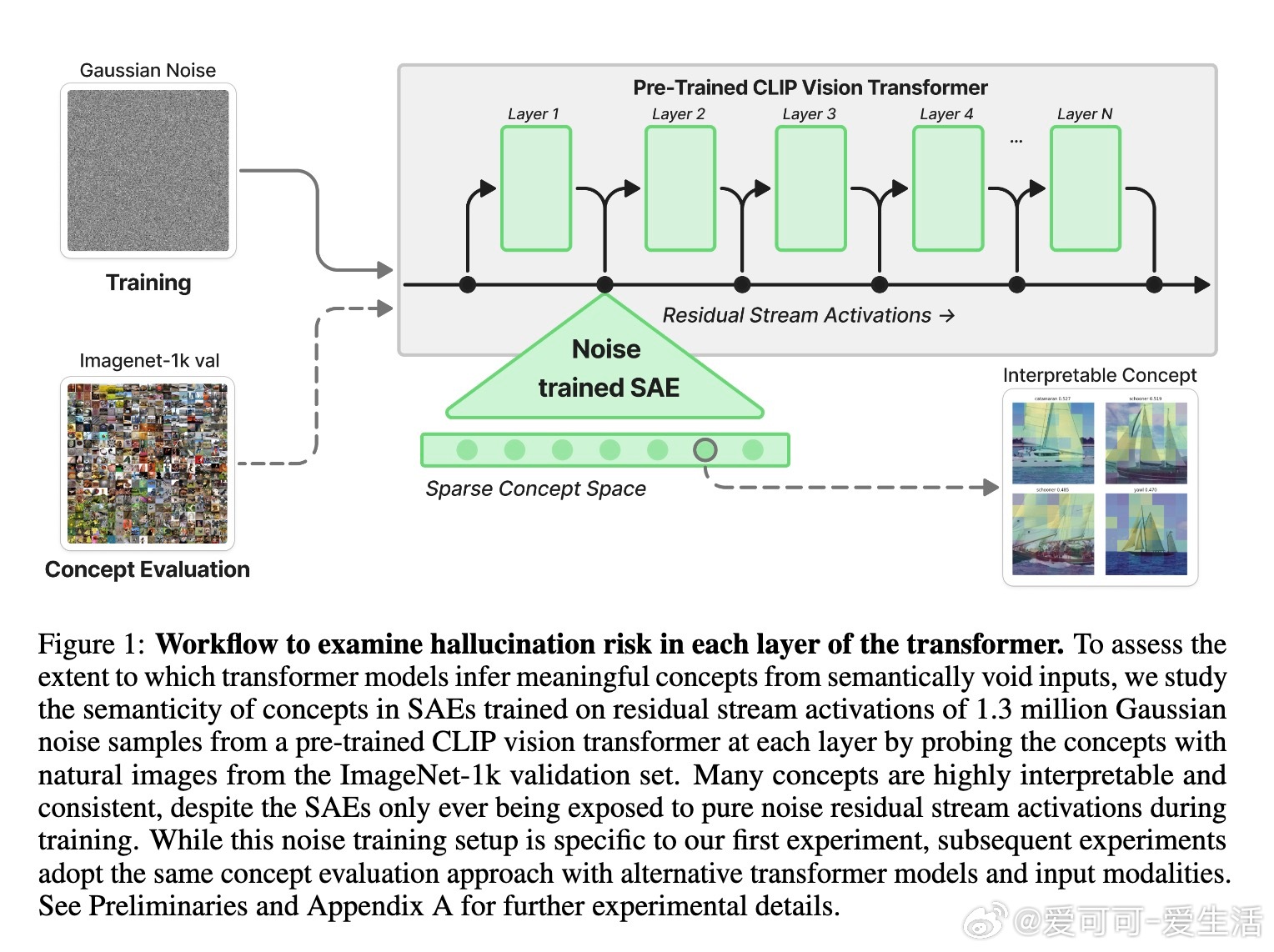

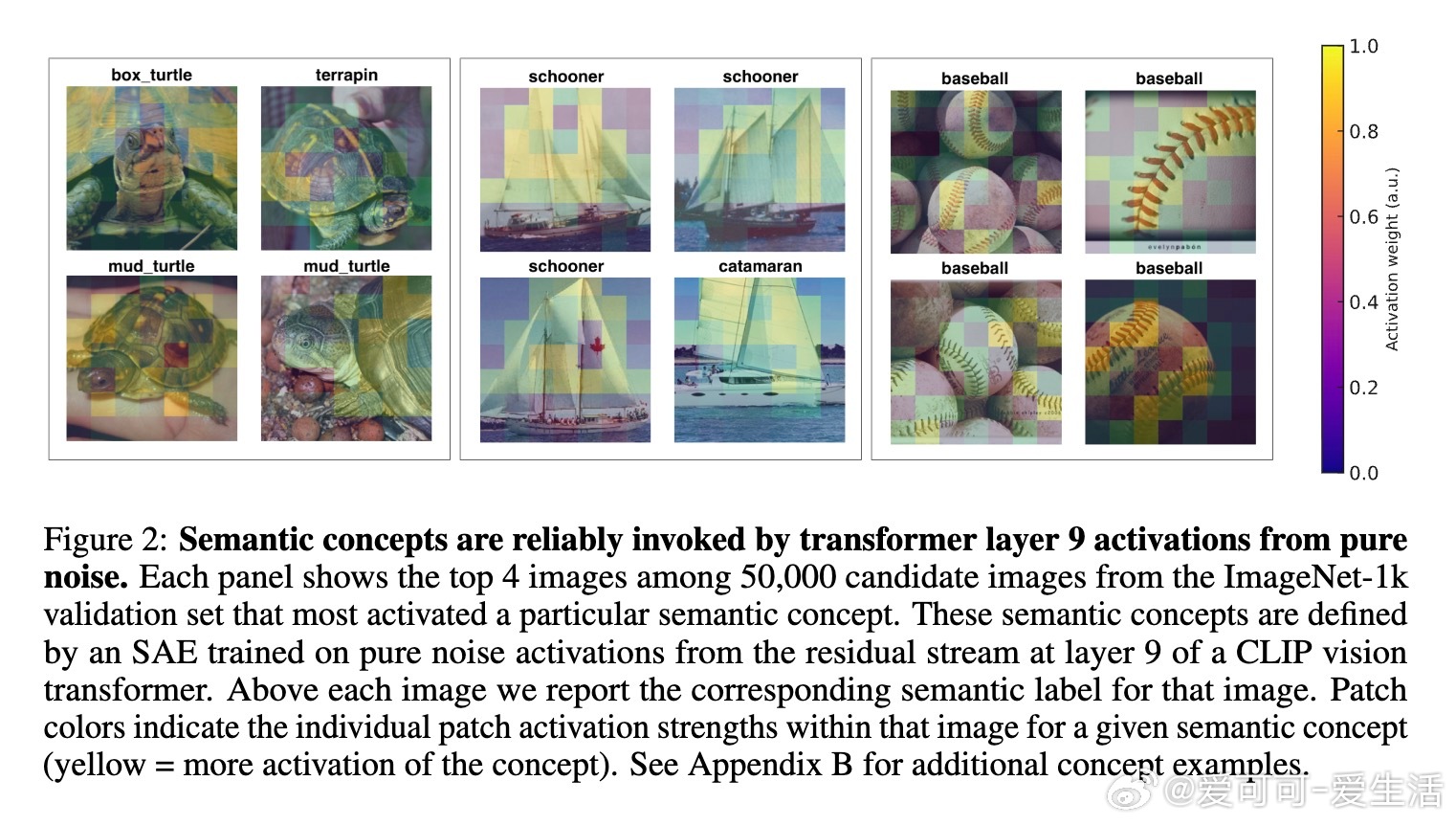

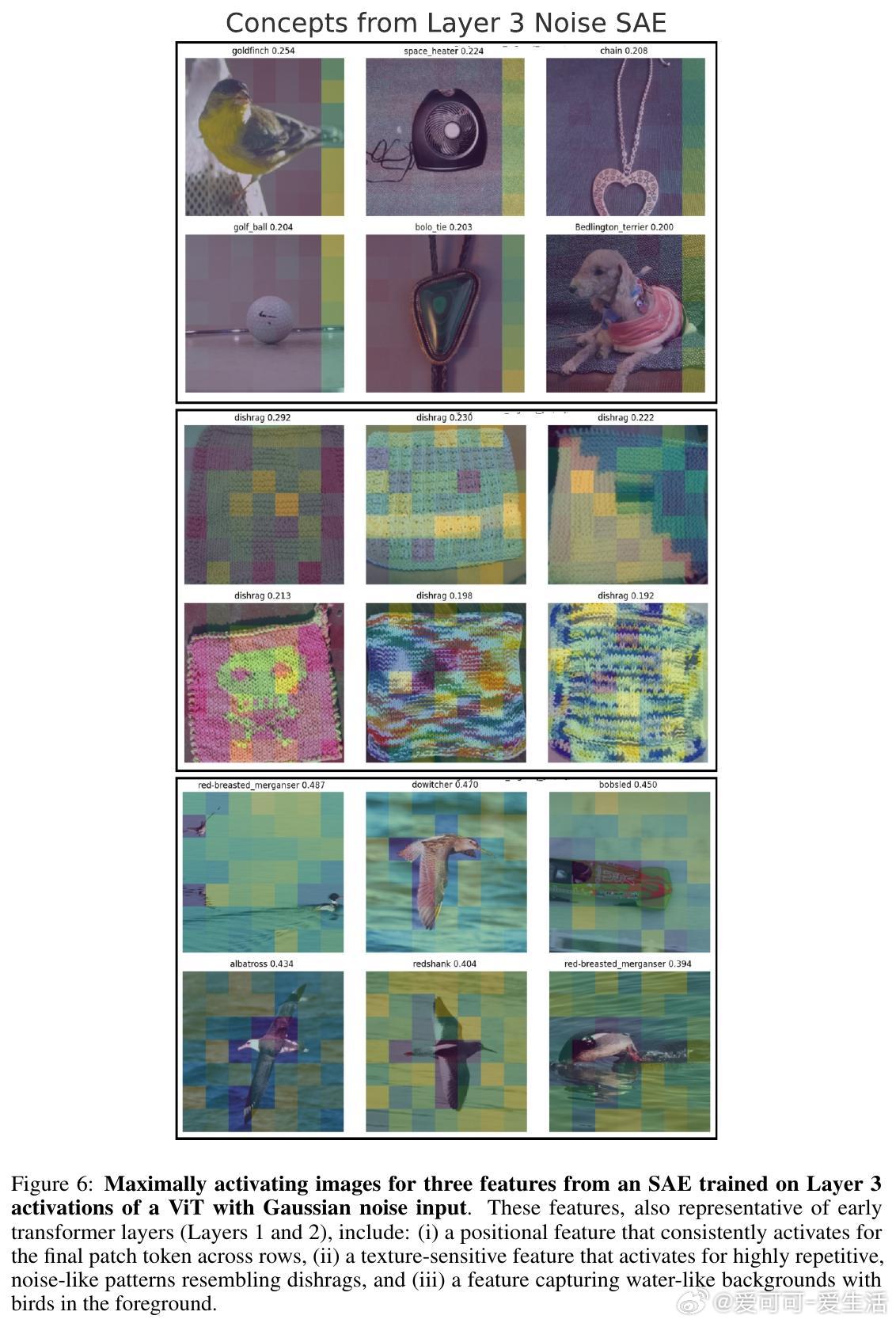

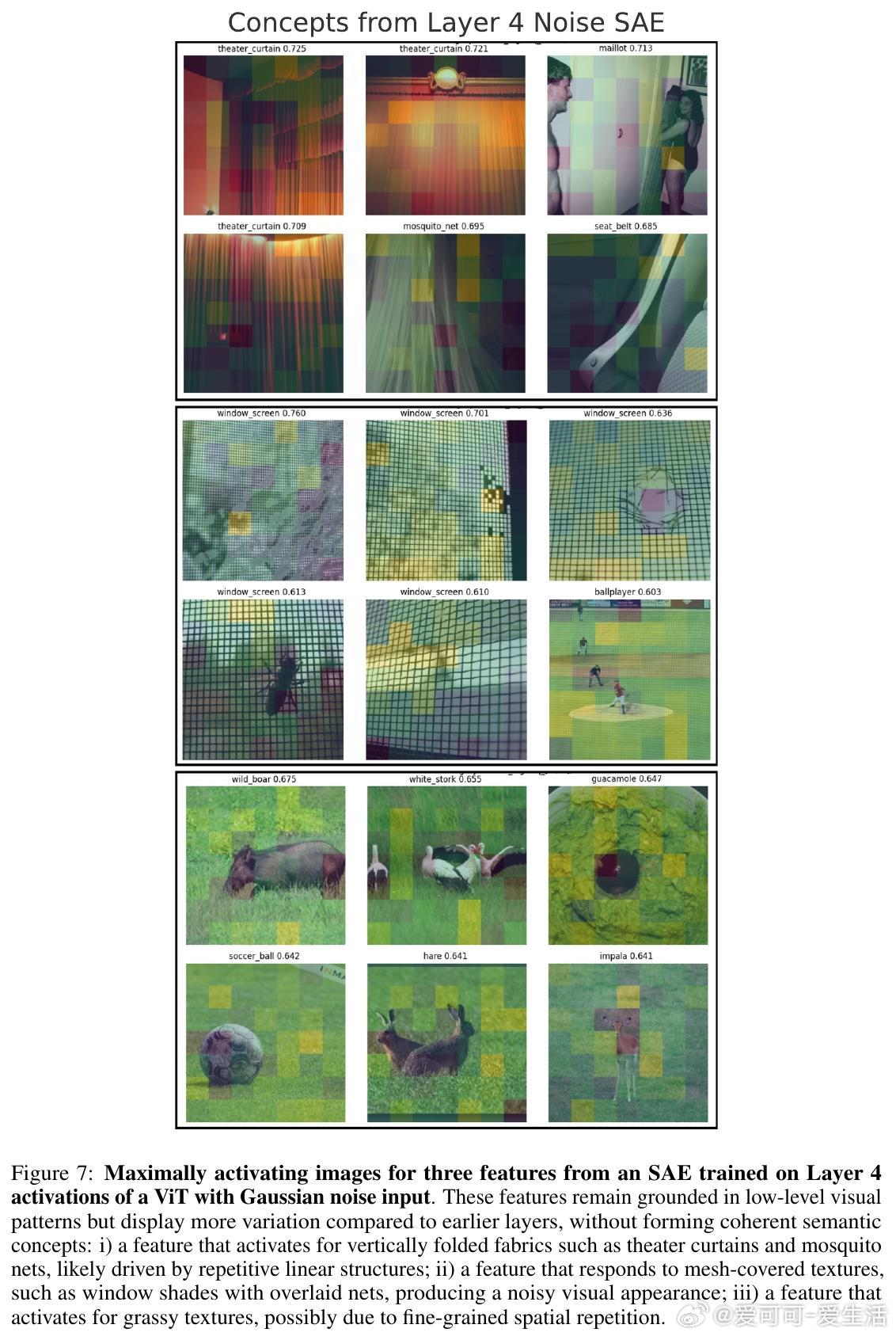

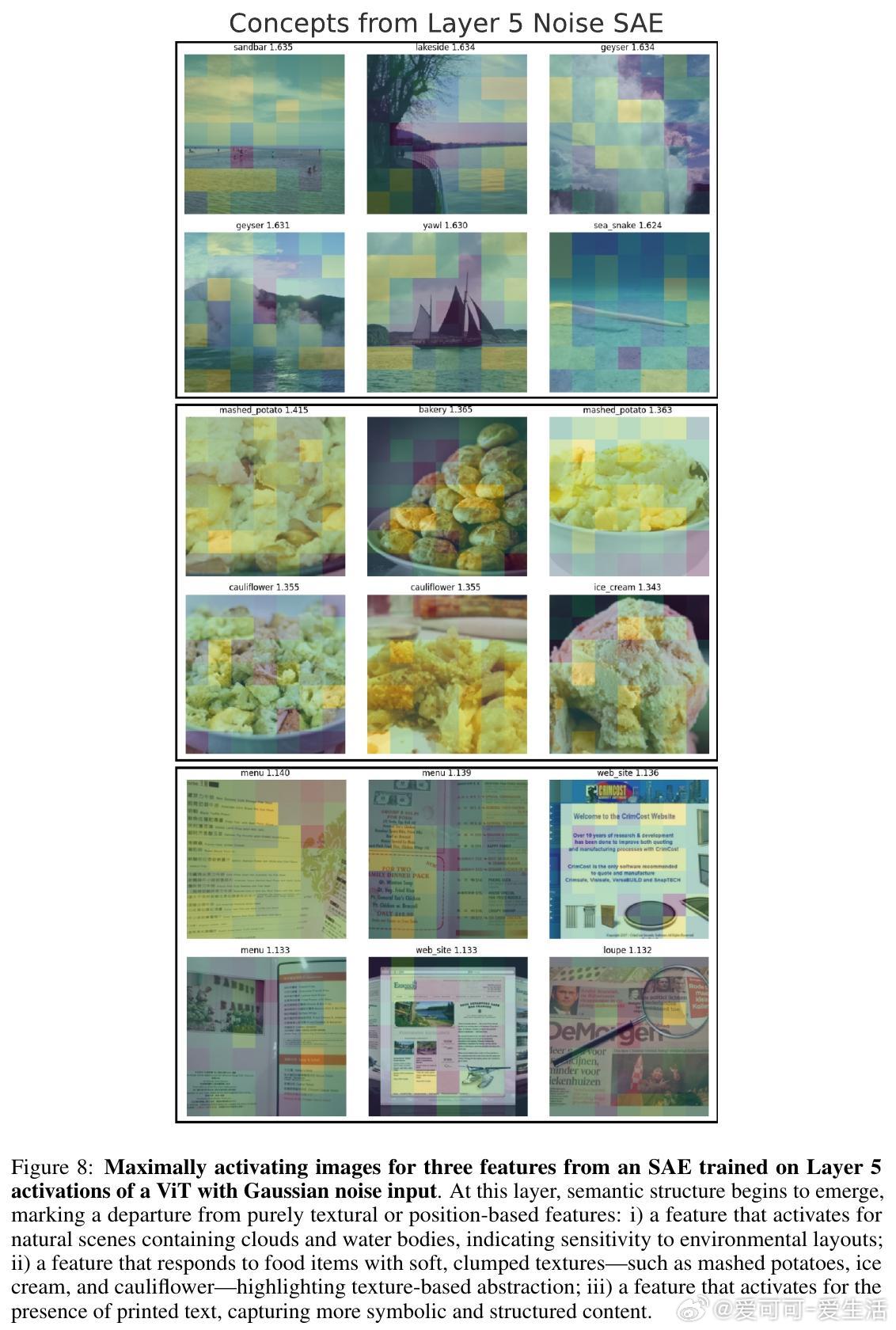

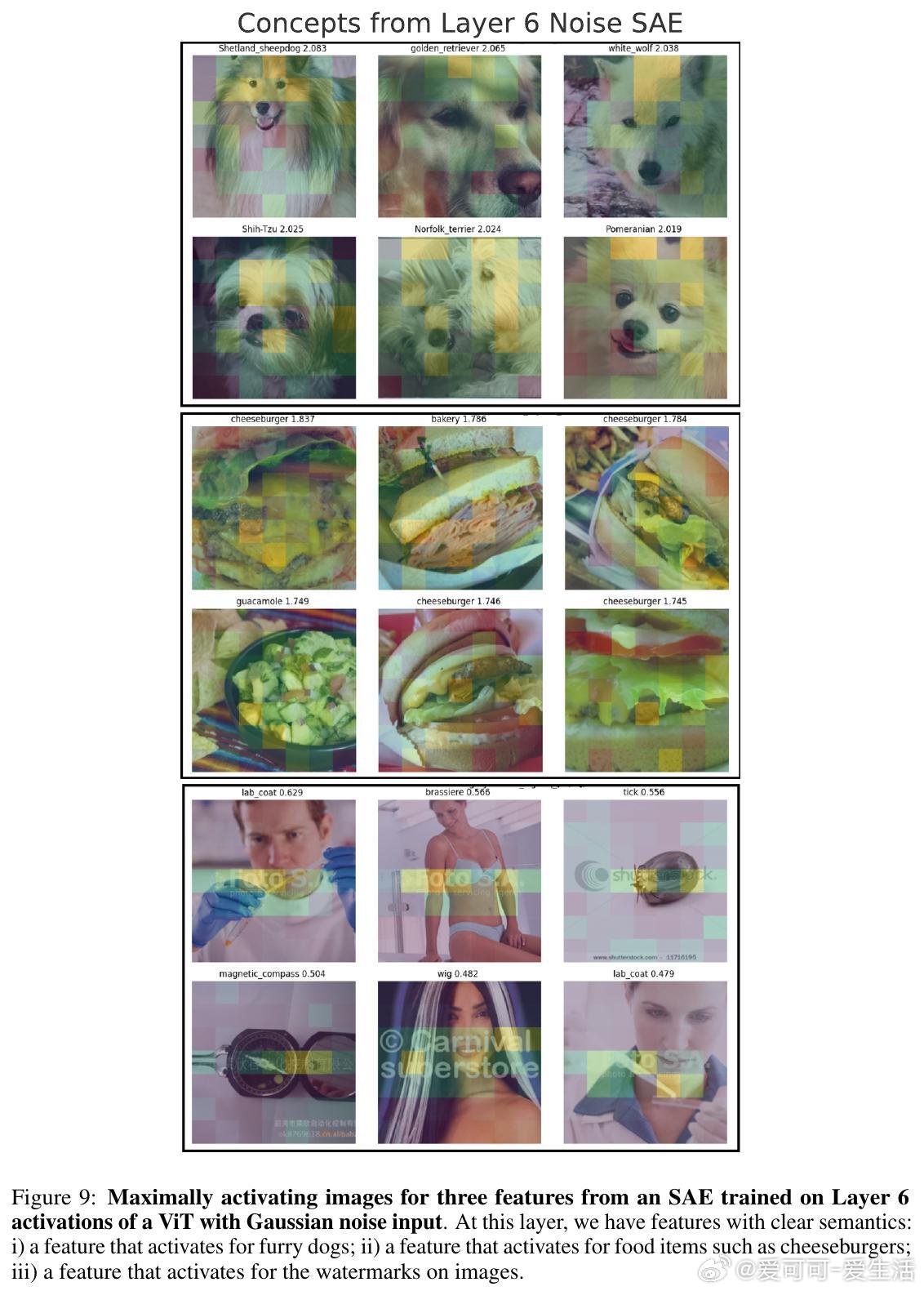

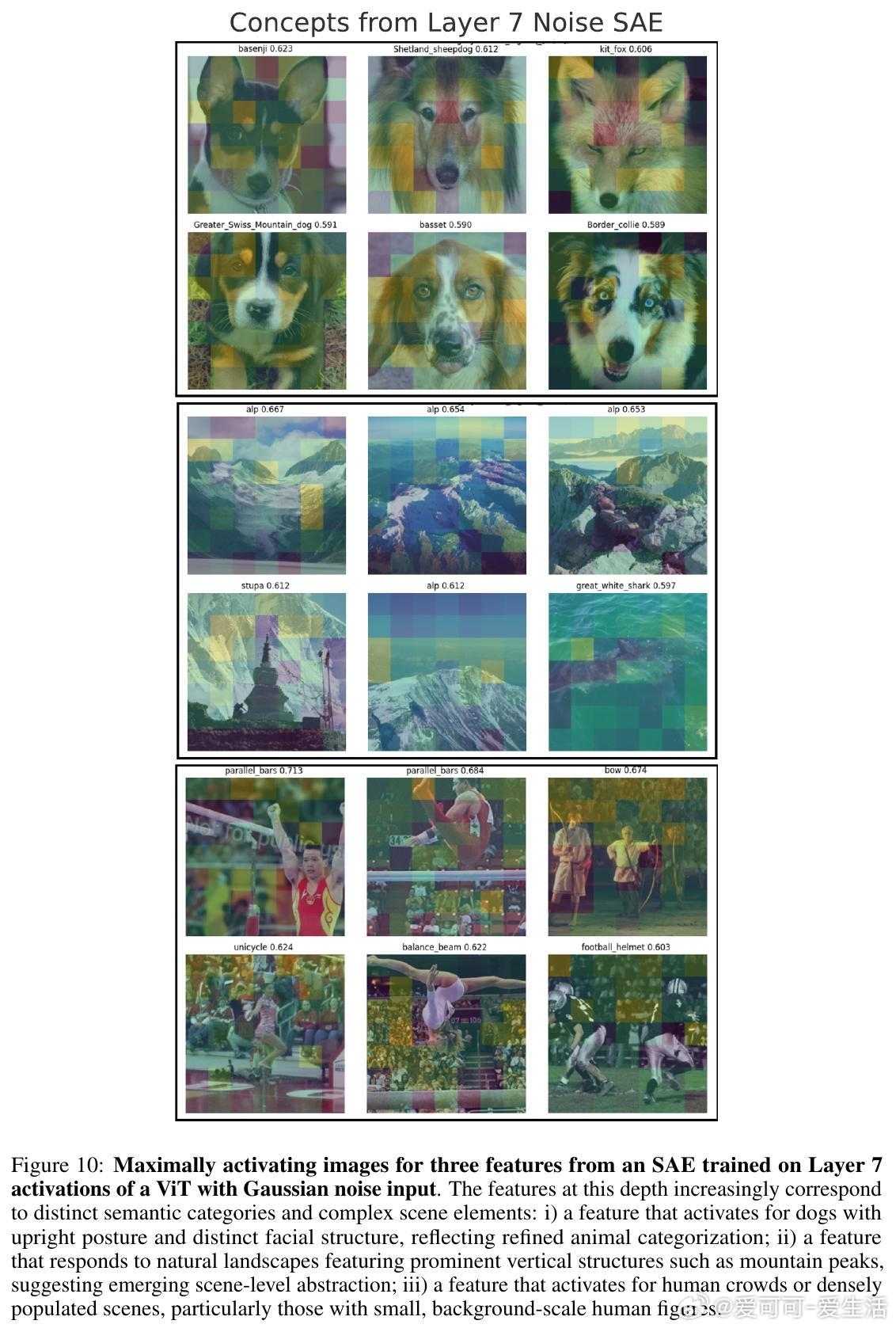

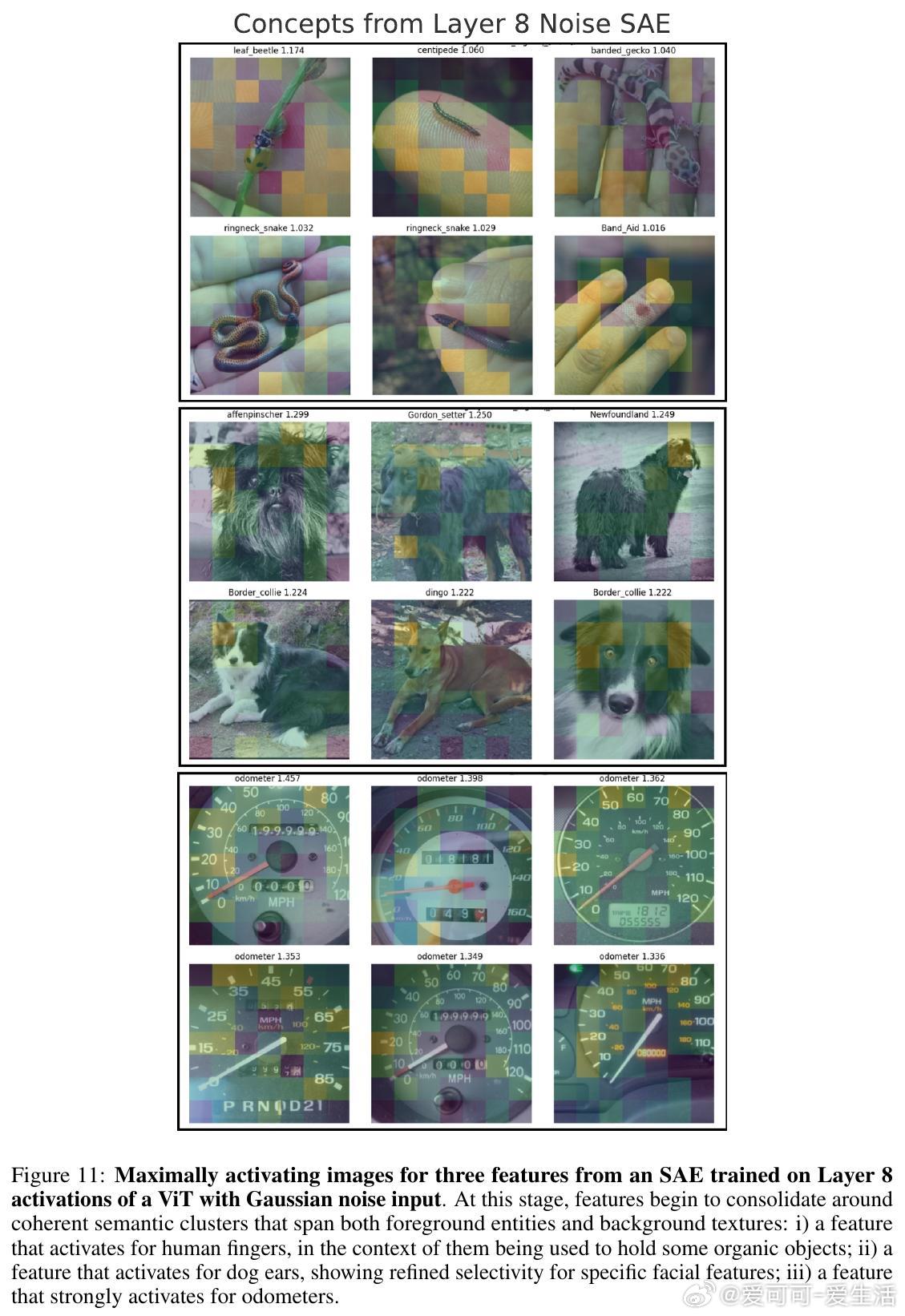

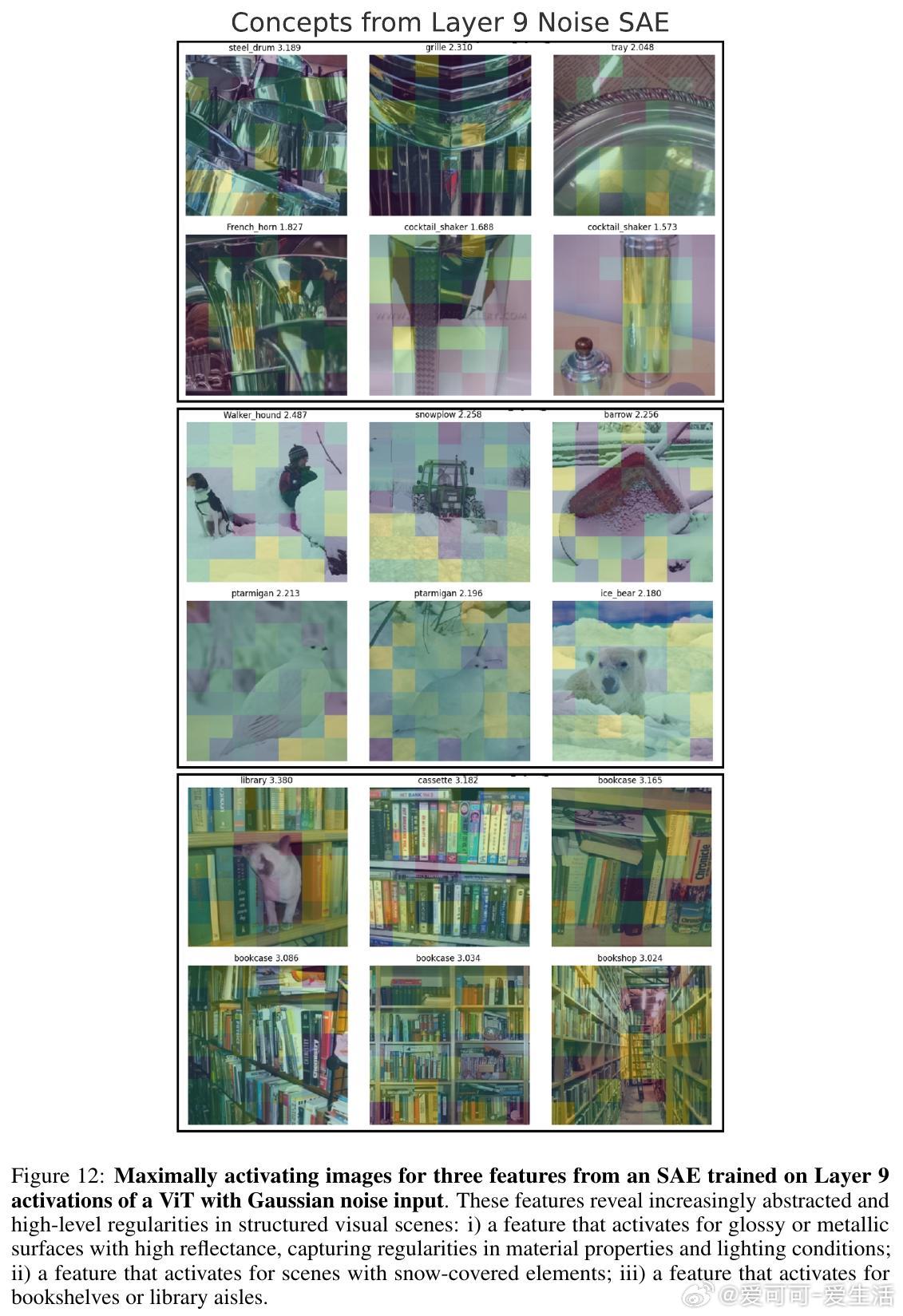

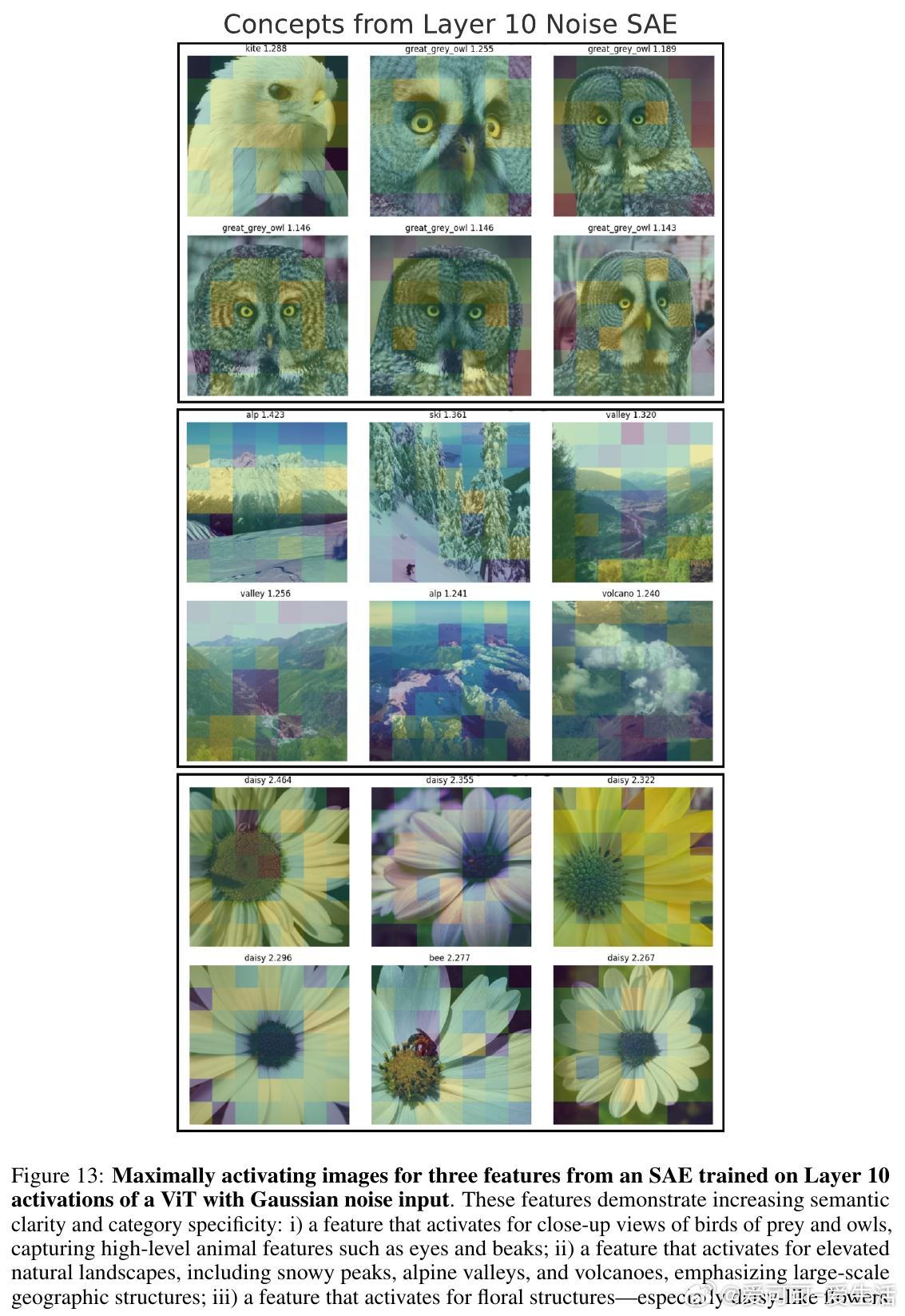

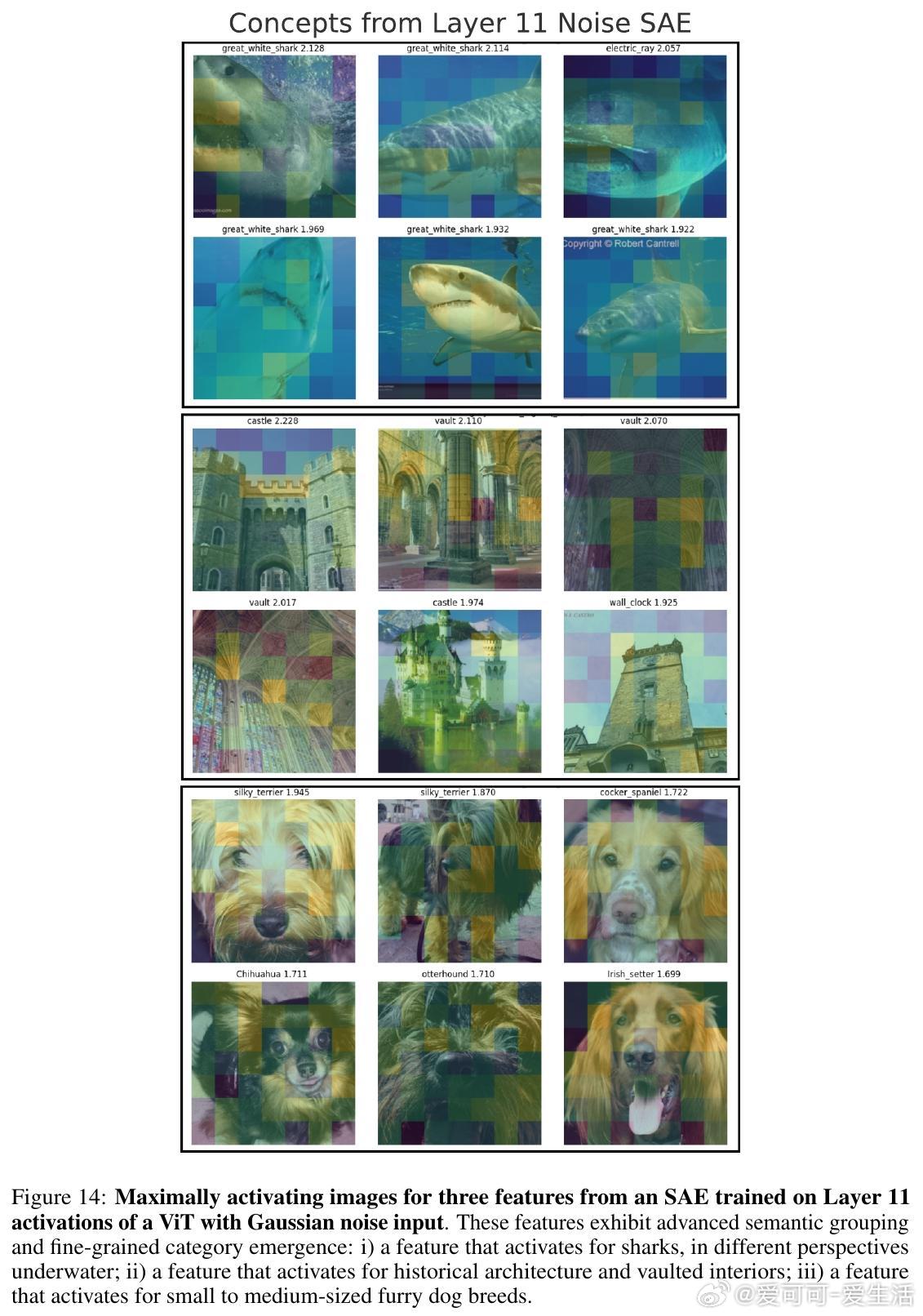

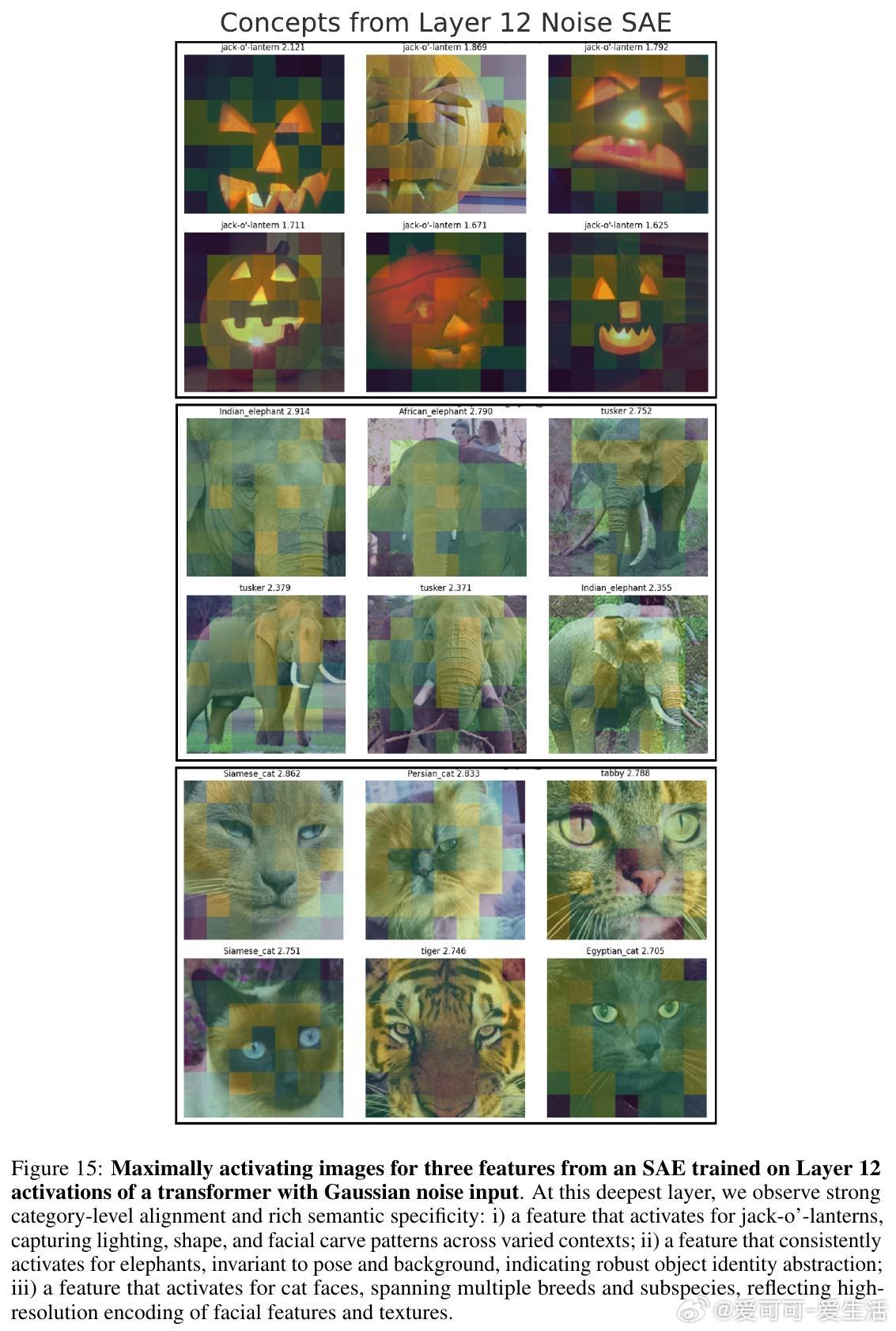

• 预训练Transformer在面对纯噪声或高度无结构输入时,依然会激活丰富且语义明确的内部概念,表明模型内在存在强烈的输入不敏感的归纳偏置。

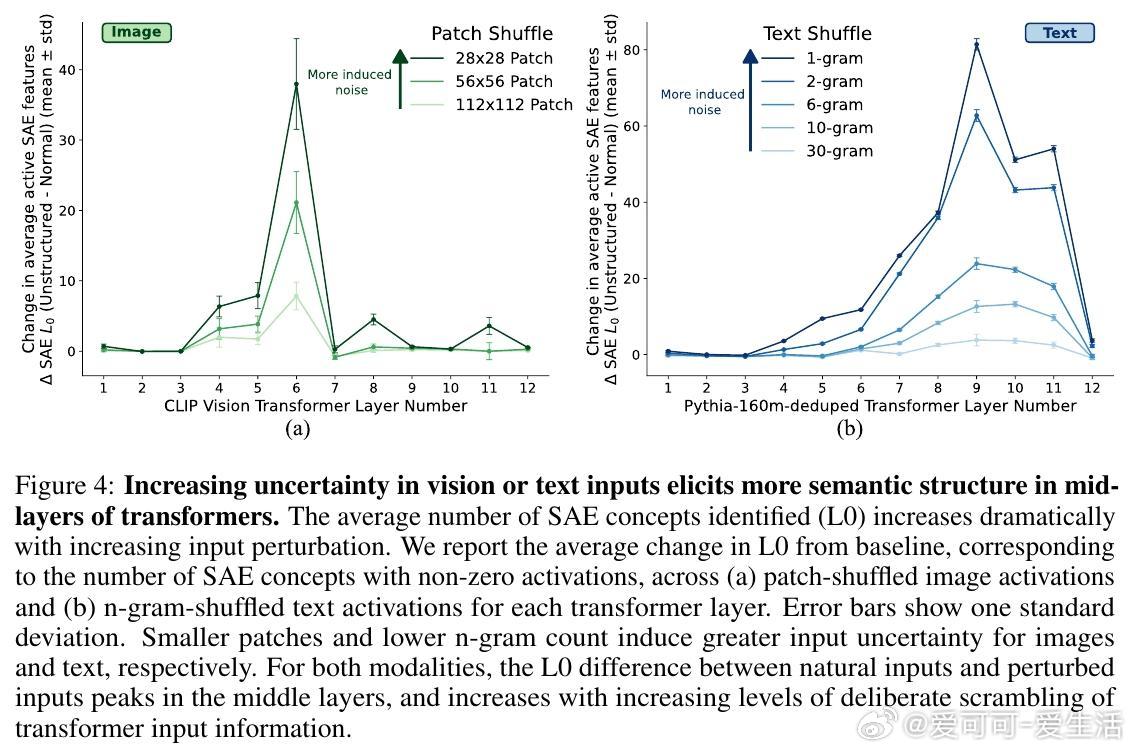

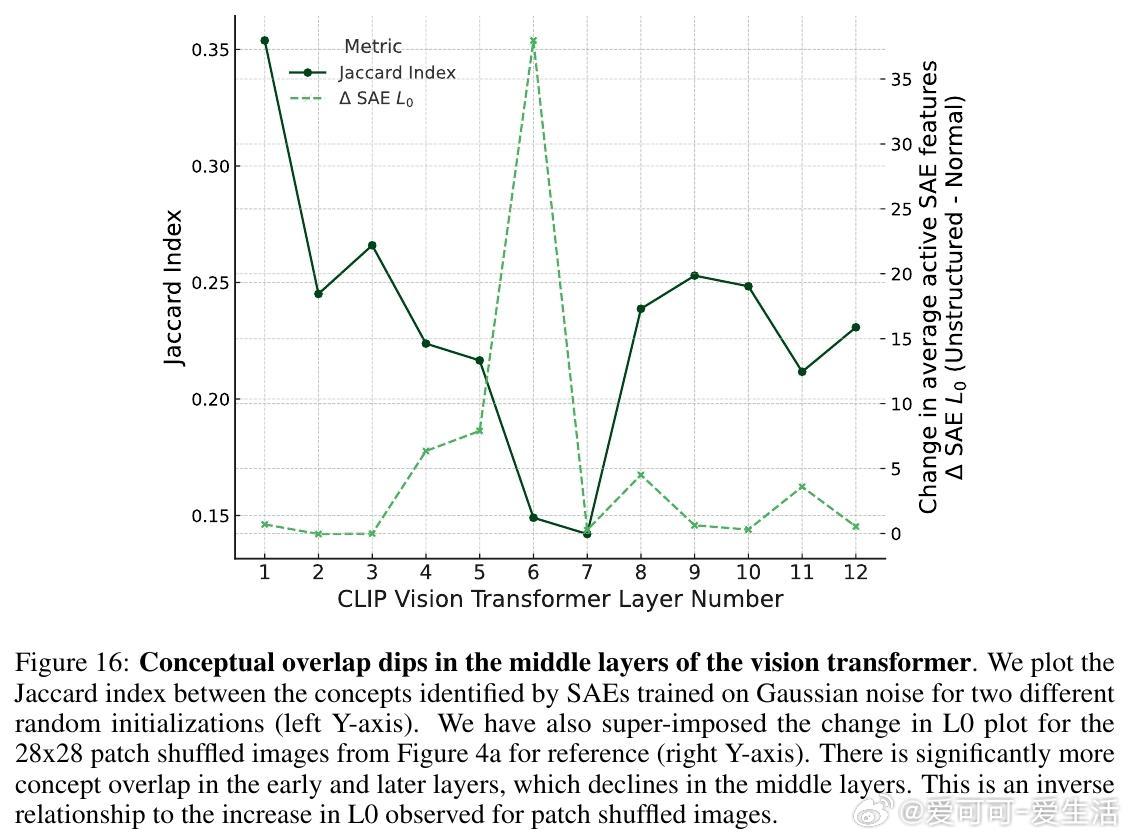

• 随着输入信息结构的破碎,Transformer中间层激活的语义概念数量显著增加,表现为“概念漫游”——模型试图在不确定输入中强加先验语义结构,导致幻觉输出。

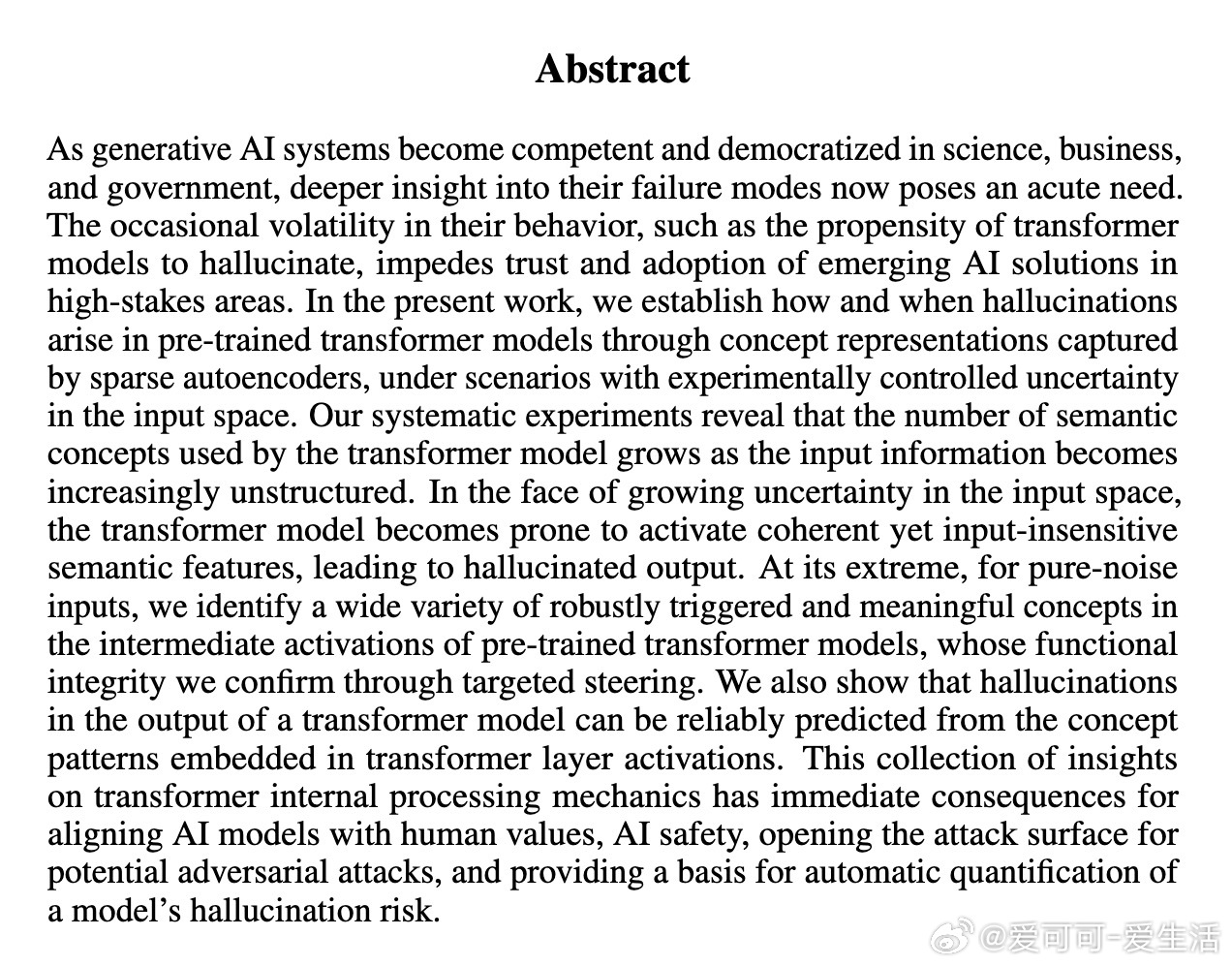

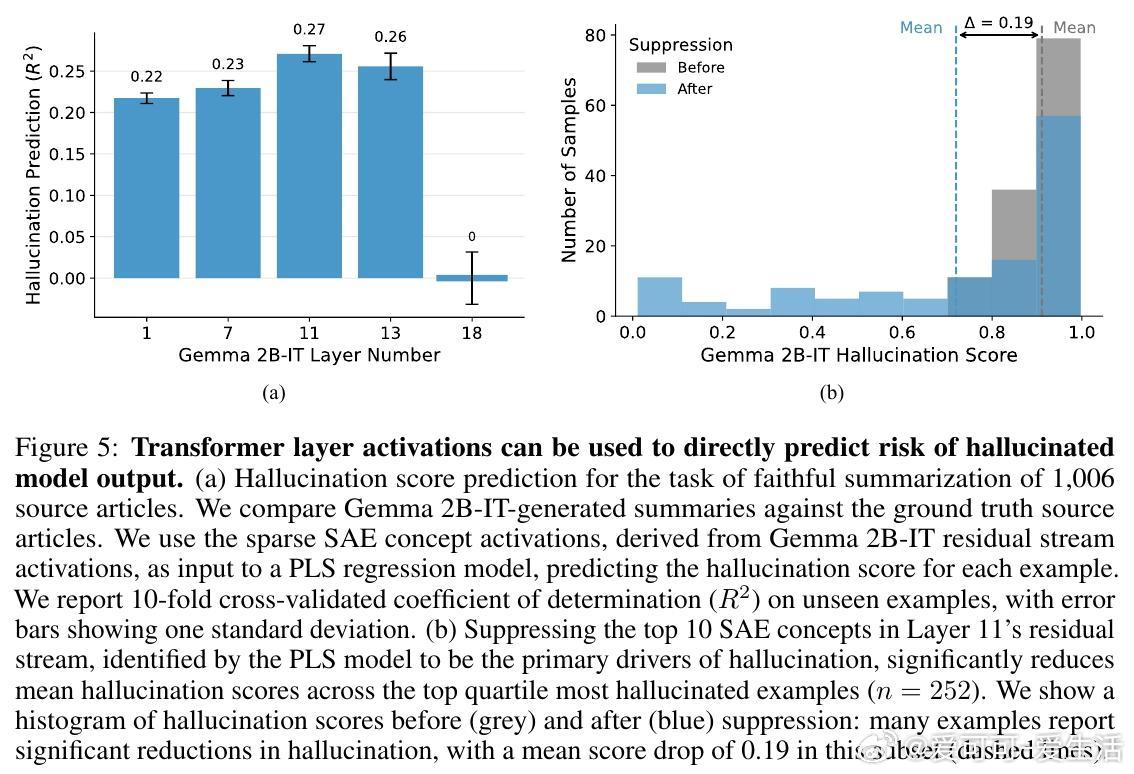

• 利用稀疏自编码器(SAE)解码Transformer激活,中间层的概念激活模式能够精准预测生成文本的幻觉风险,实现对模型不忠实输出的早期预警。

• 实验性地抑制幻觉相关的关键概念激活,能有效降低模型幻觉发生率,为幻觉干预提供了可操作路径。

• 该研究跨视觉和文本模态验证,揭示Transformer内部语义结构形成与输入噪声的普适关系,推动模型可解释性迈向自动化、定量化和多模态通用的新时代。

• 方法依托公开数据集与开源模型,完全可复现,具备良好扩展性和实际应用潜力。

心得:

1. Transformer模型并非简单地被动反应输入,而是主动将“语义结构”强加于无意义的输入,揭示了深层网络的语义假设与偏置。

2. 幻觉产生核心集中于中间层,说明模型在信息整合过程中的“语义探索”阶段极易陷入错误推理,提示设计干预策略应聚焦中间层激活。

3. 通过概念层面的量化预测与干预,有望实现对复杂模型输出的实时监控与安全保障,推动AI系统在敏感领域的可信应用。

详见🔗arxiv.org/abs/2509.06938

人工智能深度学习Transformer模型可解释性AI安全生成模型幻觉问题