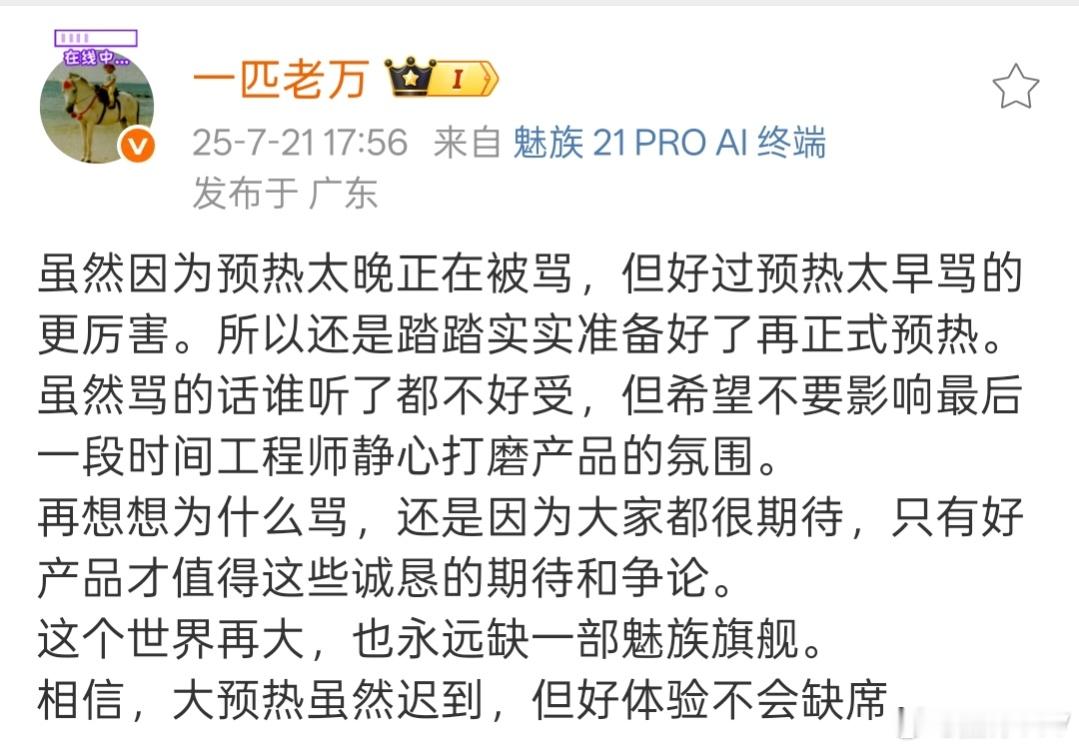

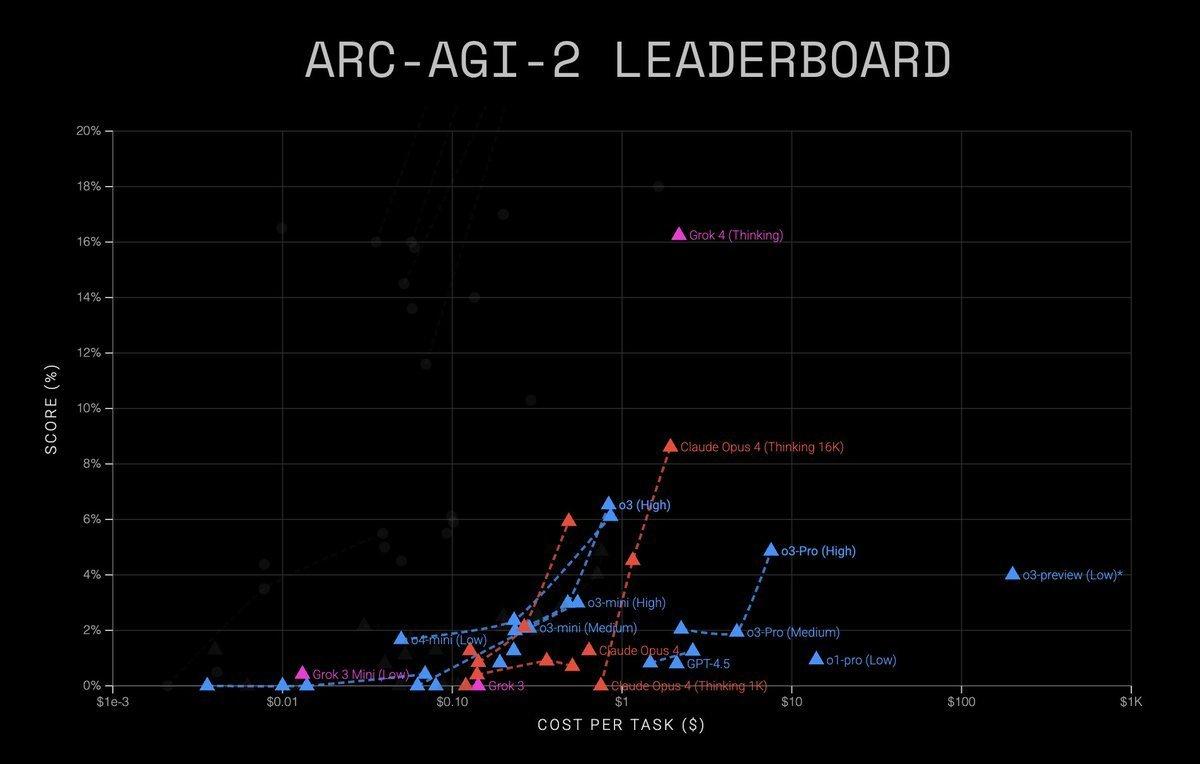

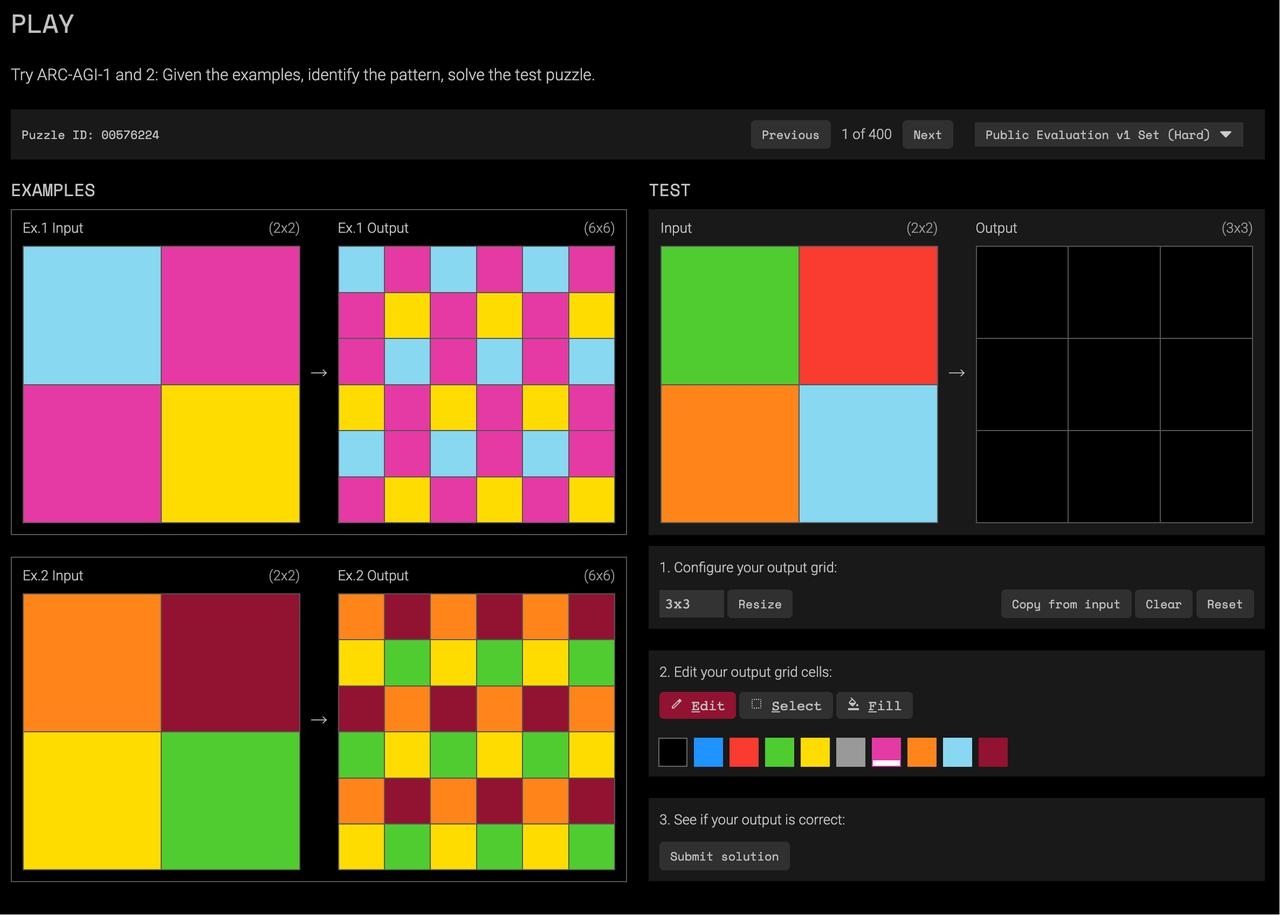

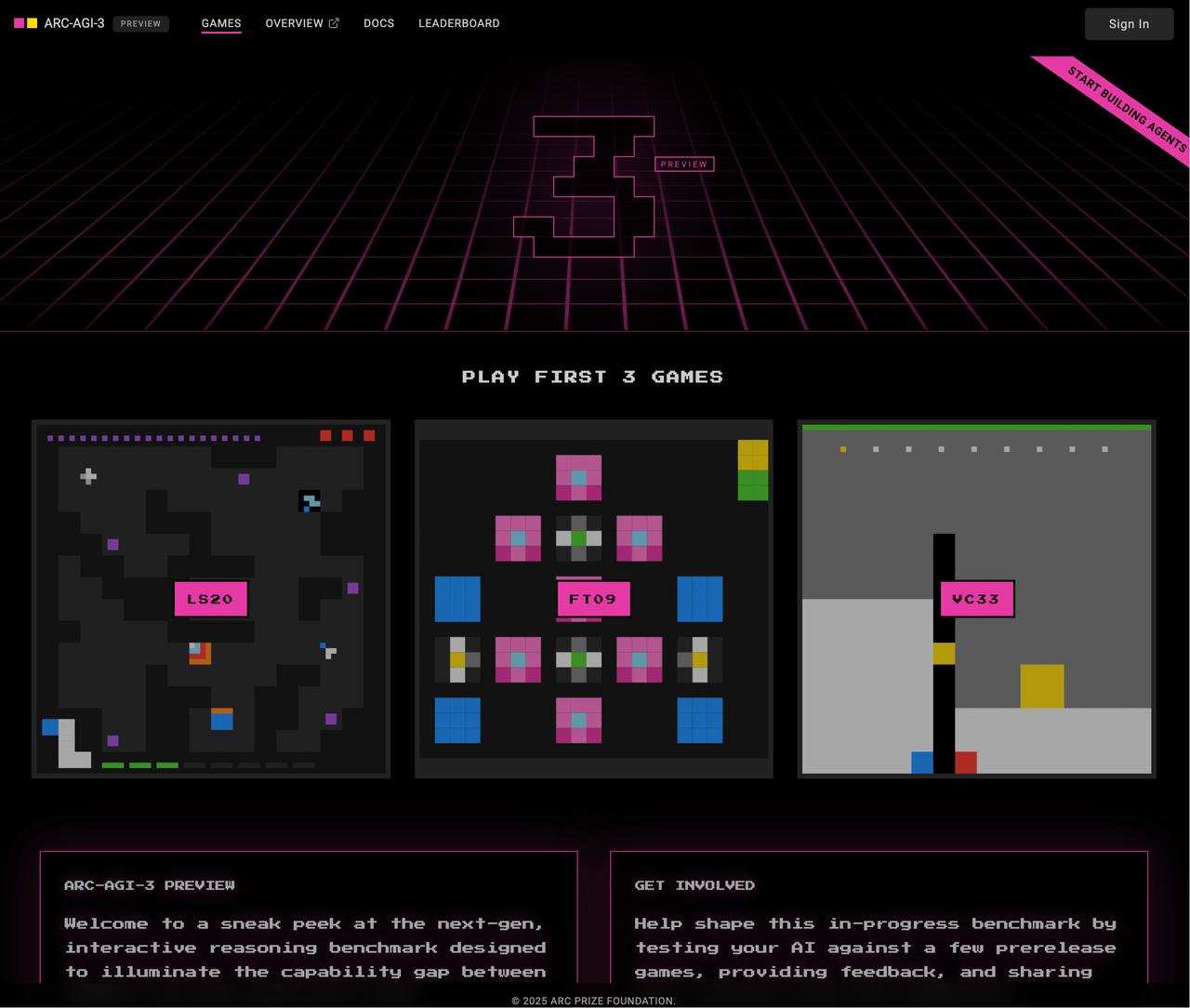

#一堆像素格子难倒AI##ARC-AGI-2为什么难# 谁能想到,一堆像素格子游戏竟然成为了AI的阿喀琉斯之踵? 看过Grok 4发布会的,可能对这个超难的ARC-AGI-2测试还有些印象,哪怕是最强的Grok 4,也仅仅取得15.9%的准确率。【图1】 为何这些人类一眼能搞定的小小益智题,却能难倒能写论文、编代码、考研究生都不在话下的AI呢? ARC(Abstraction and Reasoning Corpus),是Keras之父François Chollet在2019年开发出来的。 它的测试思路是:教你问题中的一项小技能,然后要求你演示这项小技能。也就是说,它衡量的是模型在限定领域内的学习能力。 人类几乎可以靠直觉做出正确解,但AI就像掉进了迷宫。它们太依赖大量数据和训练,根本没法像人类一样,只需观察问题并参考一两个示例,就能灵活运用。 最新一代ARC测试(ARC-AGI-3)甚至把格子题升级成了电子游戏,每一关都是一个全新的环境和规则,目的是测试AI在互动、探索和规划上的表现。【图4】 开发者说,目前没有任何一个AI能打通哪怕一关。 ARC的标准很明确:只测试那些人类能做但AI做不了的问题。只要这样的差距还存在,我们就还不能说AI拥有真正的通用智能(AGI)。 总结来说:AI可以在熟悉的场景中表现出超强能力,但面对陌生情况,它还有很长的路要走。 感兴趣的朋友,可以自己尝试一下: ARC-AGI-1: ARC-AGI-2: ARC-AGI-3:

![魅族22,预热的预热[doge],7月是发不了了,盛夏见还有8月份。](http://image.uczzd.cn/3999849197287201368.jpg?id=0)