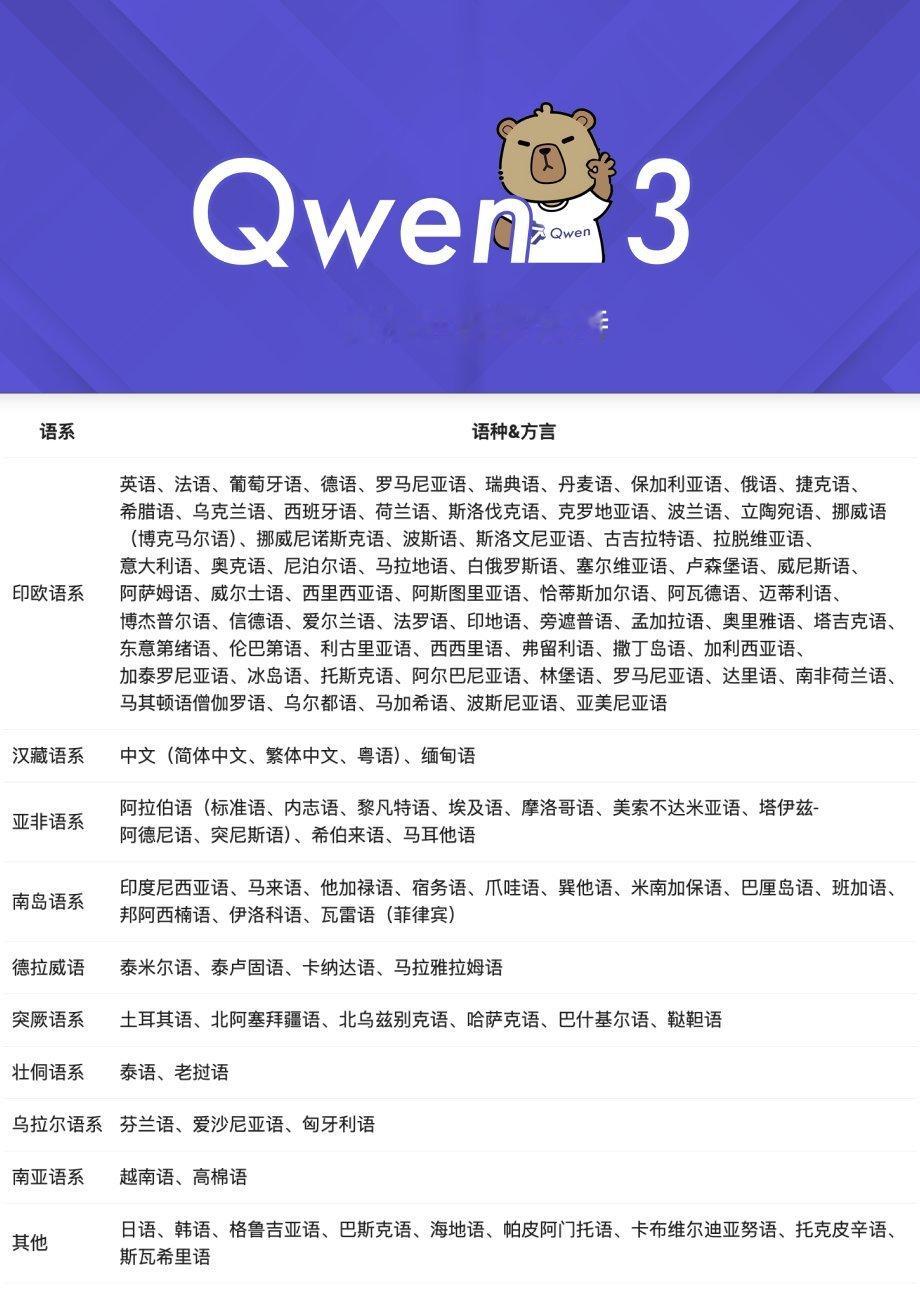

艾伦人工智能研究所的post-training研究负责人Nathan Lambert发了篇博客来介绍他对Qwen3的分析及看法,题目给拔得很高《Qwen 3 新一代开源标准》

链接:www.interconnects.ai/p/qwen-3-the-new-open-standard

其主要观点:

⭐这次发布是对 DeepSeek R1 的配方和通用蒸馏技术的重要验证。正如 DeepSeek 在其 R1 报告中讨论的那样,较小的 Qwen3 模型通过更多的强化学习训练可能可以得到进一步的改进。

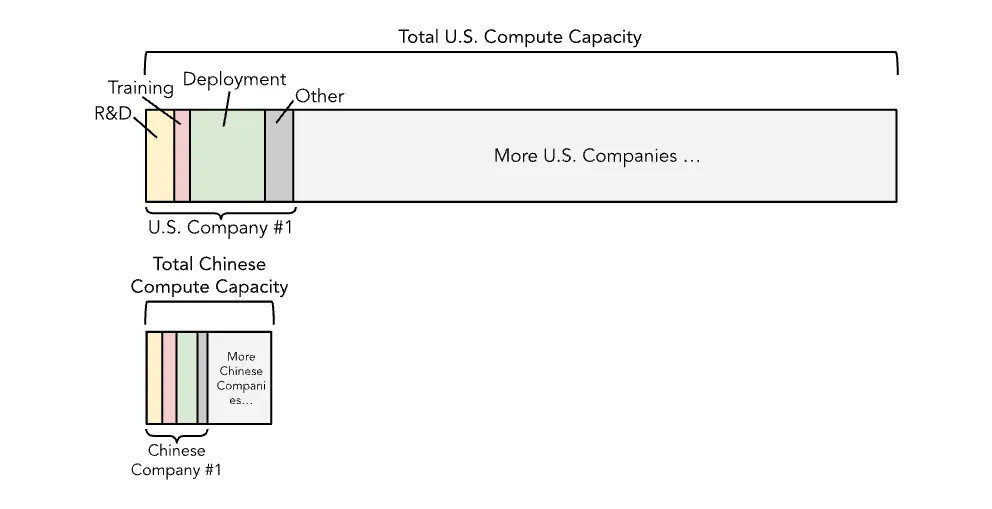

⭐预训练的 token 数量非常惊人(与 Llama 4 的预训练量相当,Scout 大约为 40T,Maverick 多模态约为 22T;或者 DeepSeek V3 的约为 15T)。Qwen 详细说明他们使用了超过 30T 的通用数据和 5T 的“高质量”数据,这比我们在 Ai2 用于 OLMo 的整个训练预算(或者其他较小的开源模型机构的产出)还要多。

⭐Qwen3 本身不是多模态的,因此相对于 Llama 4 以及似乎正在转向像 GPT-4o(也许还在 YouTube 上训练)这样更早融合的行业而言,他们可能在这方面有所损失。社区正在寻找具有工具使用和视觉能力的模型,以构建计算机使用代理。

⭐对于开源模型而言,Qwen3 是两全其美的选择——既有 DeepSeek 领先模型的峰值性能和尺寸规模,又有像 Llama 1、2 和 3 那样完全可访问的模型尺寸套件。

⭐Qwen3 展示了算法和数据的改进如何使模型变得更小。官方博客文章详细介绍了大约 50% 的密度提升:“例如,Qwen3-1.7B/4B/8B/14B/32B-Base 的性能分别与 Qwen2.5-3B/7B/14B/32B/72B-Base 相当。”这些数字被夸大了,因为 Qwen 2.5 并非一套推理模型,并且现代的后训练技术使得在目前流行的评估指标上实现了惊人的性能提升。

⭐在 ICLR 关于开源模型的一个研讨会小组讨论中,来自 Qwen 的林俊旸大致表示,他们“需要 100 人才能做出一个好的通用模型”。

⭐许可非常好,所有较小的模型都采用了 Apache 2.0 许可,而 Qwen 的许可在历史上比 Llama 宽松得多。过去,当你对用 Qwen 构建的模型进行微调时,你可以选择你的许可,并在模型文档中添加“built with Qwen”这样的声明。

⭐开源模型中的工具使用非常有趣且难以快速测试。Llama 也具备这种能力,这可能是 2025 年开源模型领域一个值得关注的持续主题。

⭐我们将开始观察 Qwen 是否具有独特的风格或特点。他们已经完成了基准测试,现在我们将观察他们在保持前沿地位方面如何与 R1、o3 和 Gemini 2.5 Pro 等模型相比较。

⭐我从有限的试验和阅读我在线认识的人的看法来看,这些模型并不像我们今天习惯使用的最佳模型那样强大。但这仍然是一项重大成就,也是实验室的正常发展路径——先获得基准分数,然后弄清楚如何做出用户喜欢的东西。基准测试的令人兴奋之处通常在于打开了顶部的流量入口,吸引人们尝试你的模型,这反过来又会带来有价值的提示和用户数据。

Qwen3发布都有哪些亮点 AI创造营